Computerhirn jagt Highscores: Auch Computer sind fähig, mit nur minimaler Vorinformation Neues zu lernen, wie eine von Google-Forschern entwickelte künstliche Intelligenz belegt. Das Deep Q-Network getaufte Programm lernte selbständig und ohne viele Vorinformationen, 49 Atari-Spieleklassiker von Space Invaders bis Breakout zu spielen. Nach kurzem Training kam es dabei den Highscores menschlicher Spieler sehr nahe, wie die Forscher im Fachmagazin „Nature“ berichten.

Unser Gehirn leistet im Alltag ständig Schwerstarbeit. Denn es muss unzählige verschiedene Reize auswerten, aus diesen die wichtigen herausfiltern, ihre Bedeutung erkennen und sie mit vergangenen Erfahrungen abgleichen. Erst durch diese Kombination aus Reizen, Erinnerungen und positiven oder negativen Verstärkungen lernen wir – beispielsweise wie wir in einem Computerspiel möglichst weit kommen können. Die Lernfähigkeit von Computern und Robotern ist im Vergleich dazu eher beschränkt und funktioniert nur in wenigen eng umgrenzten Anwendungsbereichen gut.

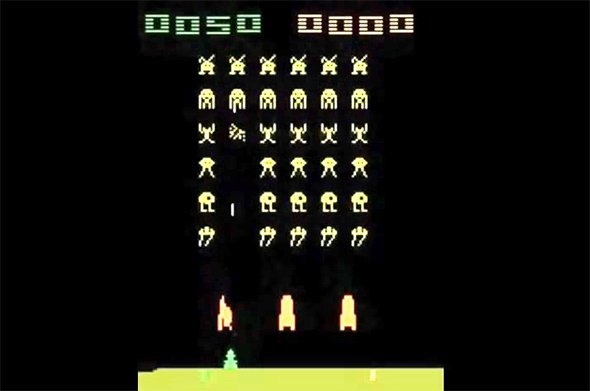

Computerhirn spielt Space Invader

Doch Volodymyr Mnih und seine Kollegen vom Projekt Google DeepMind in London haben nun eine künstliche Intelligenz entwickelt, die ohne viel Vorwissen direkt aus eingehenden Reizen lernen kann. Das Deep Q-Network (DQN) genannte System basiert auf einem neuronalen Netzwerk mit hierarchischen Filterschichten. Ähnlich wie unser Gehirn lernt dieses Netzwerk durch positive Verstärkung: Bringt eine Aktion Erfolg, wird sie beibehalten. Bringt sie keinen, wird sie beim nächsten Mal verändert.

Um das Programm testen, ließen die Forscher es selbstständig 49 verschiedene Videospiel-Klassiker lernen, die früher auf dem Atari 2600 liefen. Unter diesen sind Autorennspiele wie Enduro, Schießspiele wie Space Invaders, aber auch einfache Strategiespiele wie Breakout. Die Regeln und vor allem die Strategien, die zu einem möglichst hohen Highscore führen, unterscheiden sich jeweils. „Damit wollten wir demonstrieren, dass unser System auf Basis nur minimaler Vorinformationen robuste Strategien für ganz unterschiedliche Spiele lernen kann“, betonen Mnih und seine Kollegen.