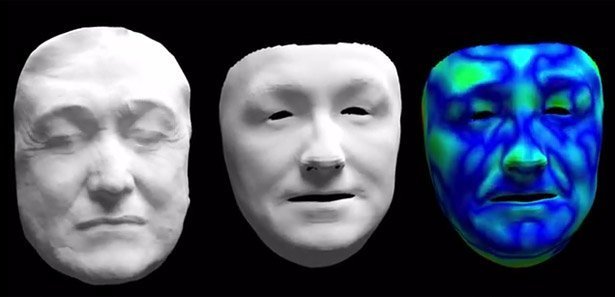

Im wahrsten Sinne in den Mund gelegt: Die Mimik und Lippenbewegungen eines Sprechers überträgt ein internationales Forscherteam in Echtzeit auf das Videosignal eines anderen Menschen. Gestik und Kopfbewegungen bleiben dabei perfekt erhalten. Mit der raffinierten Bilderkennungstechnik sollen etwa bessere Filmsynchronisationen möglich sein – aber auch Live-Übertragungen sind damit anfällig für Manipulationen.

Live-Übertragungen im Fernsehen bringen wichtige Momente direkt ins Wohnzimmer, vom Fußball-Finale bis zu Ergebnissen der Bundestagswahl. Wir erfahren solche Ereignisse so unvermittelt und vor allem unverfälscht. „Live“ bedeutet für uns, dass wir tatsächlich sehen was geschieht.

Dynamische Videos als Herausforderung

Doch mit einem System, das Wissenschaftler um Christian Theobalt vom Max-Planck-Institutfür Informatik (MPII) in Saarbrücken entwickelt haben, wäre diese Unverfälschtheit nicht mehr so sicher: Ein Nachrichtensprecher etwa könnte auf dem Bildschirm sprechen, während er in Wahrheit nicht einmal den Mund öffnet – jemand anders steuert die Mundbewegungen täuschend echt.

Video-Streams zu manipulieren ist aber nicht das Ziel der Wissenschaftler: Sie beschäftigen sich schon lange mit dem „Verstehen von Bildern“ – mit der Herausforderung, dynamische Szenenmodelle von Videos zu erfassen. „Insbesondere geht es darum, Modelle aus Videodaten zu berechnen, um eine mathematisch, möglichst realitätsgetreue Beschreibung von starren, beweglichen aber auch deformierbaren Körpern innerhalb einer Szene zu schätzen“, sagt Christian Theobalt vom MPI. Genau das scheint den Forschern nun mit ihrem System geglückt zu sein.