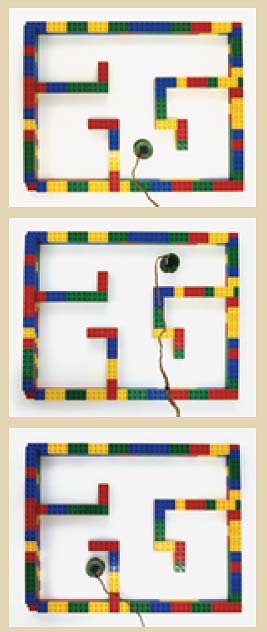

Neuronale Netze, wie Herrmann und sein Team sie untersuchen, lernen, ohne zu wissen, was. Etwa mittels eingebauter Verstärkungsmechanismen. Ein Beispiel: Der Käferroboter im Labyrinth – nennen wir ihn Rob. Er ist auf den ersten Blick erstaunlich einfach gestrickt: Der Output seines neuronalen Netzwerks ist lediglich eine Zahl, die das Geschwindigkeitsverhältnis zwischen den beiden Antriebsrädchen des Roboters beschreibt; auf der untersten Ebene des Netzwerks sitzen Neuronen, die feste Geschwindigkeitsverhältnisse in Form verschiedener Zahlen zwischen null und eins gespeichert haben.

Robs Leben und Lernen funktioniert nach wenigen, einfachen Regeln. Erstes Gesetz: „Bewege dich.“ Zweites Gesetz: „Halte das Geschwindigkeitsverhältnis deiner Rollen nach Möglichkeit konstant – fahr geradeaus.“ Umgesetzt werden diese Gesetze auf simple Weise: Wenn Rob nicht geradeaus fahren kann – aus welchen Gründen auch immer –, gibt es eine Strafe, das heißt, die Neuronen seines Netzwerks müssen ihre Inputleitungen nach einer speziellen Lernregel neu gewichten. Das bedeutet: Andere Neuronen als die, die den Output derzeit bestimmen, können stärker zum Gesamtergebnis beitragen.

Wenn es geradeaus geht, gibt es dagegen eine Belohnung, die offenbar erfolgreichen Gewichtungen werden gefestigt. Bereits ein Minihirn aus etwa 100 Rechnerneuronen reicht aus, um mit diesen einfachen Regeln komplexes Verhalten zu generieren: Es reicht sogar, um Rob ein Bild von seiner Welt zu verschaffen. Denn jedes Mal, wenn der Infrarotsensor des Roboters die Gegenwart eines Hindernisses meldet, ist das Netzwerk gezwungen, umzudenken. Aktive Verbindungen zwischen den Neuronen werden geschwächt, bis zuvor nicht erhörte Neuronen das Kommando übernehmen.

Mit jedem Misserfolg sinkt die Wahrscheinlichkeit, dass Rob beim nächsten Mal dasselbe macht wie vorher; stattdessen werden durch die ständige Neugewichtung der Leitungen im Netzwerk irgendwann solche Neuronen das Übergewicht erhalten, die ein anderes Geschwindigkeitsverhältnis zwischen den Antriebsrädchen fordern. Rob könnte sich dann zum Beispiel nach rechts wenden. Ergebnis: kein Hindernis mehr. Also wieder umstellen auf Geradeausbetrieb. Bis zum nächsten Hindernis.

Nach wenigen Stunden hat der Roboter gelernt, Kollisionen mit den Wänden des Labyrinths zu vermeiden. Und zwar auf eine verblüffende Weise. Denn er verfügt nach wie vor nicht über eine Karte des Labyrinths – wo sollte er die speichern? Dass er nicht mehr aneckt, liegt einfach daran, dass das neuronale Netz jede Position des Labyrinths mit einem bestimmten Erregungszustand verknüpft hat, der durch das Verstärkungslernen mit einem exakt definierten Rollengeschwindigkeitsverhältnis verbunden ist.

Es hat also nicht die Umgebung oder ein Bild davon verinnerlicht, sondern das, was an einer bestimmten Position zu tun ist, um weiter belohnt zu werden. „Das ist weit weniger ungewöhnlich, als es klingt“, sagt Michael Herrmann. „Ratten zum Beispiel orientieren sich nach demselben Prinzip.“

Stand: 27.05.2005