Seit nahezu 400 Jahren beruht die Wissenschaft auf einem klassischen Zweischritt: Experiment und Theorie. Mithilfe von Lupe, Mikroskop, Fernrohr und anderen Instrumenten suchten schon zu Galileis Zeiten Forscher nach den Gesetzmäßigkeiten und Regeln hinter den Vorgängen in der Natur. Heute sind die Instrumente der Wahl zwar eher Rastertunnelmikroskop, Weltraumteleskop oder Teilchenbeschleuniger, aber das Grundprinzip ist geblieben: Aus der Beobachtung der Phänomene schließt die Wissenschaft auf die zugrundeliegenden Prinzipien, auf die dahinterstehende allgemeine Theorie.

Aber auch der umgekehrte Prozess hat Tradition: Einige der großen Gesetze und Formeln, die heute unser Weltbild bestimmen, haben ihren Ursprung nicht unmittelbar im Experiment, sondern in der Theorie. Physiker wie Einstein, Schrödinger oder Euler entwickelten ihre bahnbrechenden Gleichungen nicht im Labor sondern am Schreibtisch. Ihre Gültigkeit wurde oft erst im Nachhinein durch Experimente oder Beobachtungen bewiesen.

Doch je weiter die Wissenschaft in die Geheimnisse der Natur eindringt, desto komplexer werden auch die Prozesse. Schon scheinbar alltägliche Wetterereignisse oder Lebensäußerungen wie die Abläufe im Inneren des menschlichen Gehirns entziehen sich der direkten experimentellen Beobachtung. Viele der aufgestellten Hypothesen und Theorien lassen sich daher nur schwer oder gar nicht am Objekt belegen oder gar beweisen.

Abhilfe für dieses Problem schafft heute eine dritte Säule der Forschung – der numerische Ansatz. Computermodelle und Simulationen schaffen virtuelle Abbilder der Natur, indem sie die Auswirkungen der bekannten Naturgesetze auf fast jede beliebige Art und Zahl von Beobachtungsdaten und Parametern anwenden können.

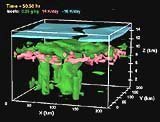

Aus einer Unmengen von Einzelwerten für Temperatur, Luftdruck, Strahlung, Wind, Wassergehalt und chemischen Bestandteilen entsteht so im Computer beispielsweise das Modell einer Gewitterwolke und der Prozesse, die in ihr ablaufen. Mit seiner Hilfe können Forscher die Veränderungen, die sich unter Einwirkung bestimmter Faktoren in der Wolke abspielen, nachvollziehen. Selbst Vorgänge, die im Inneren scheinbar undurchdringlicher Wolkenmassen ablaufen, können so im Modell sichtbar gemacht werden. Gleichzeitig lassen sich diese Ergebnisse wiederum mit den Beobachtungen in der realen Welt abgleichen und so das Modell immer wieder erweitern und verbessern.

Für Mark Boslough, Forscher am amerikanischen Sandia Laboratorium, ist die Computermodellierung schon heute neben Experiment und Theorie die dritte Säule der wissenschaftlichen Methodik. „Die Supercomputer und die mit ihnen erstellten Simulationen werden der Forschung zu neuen Durchbrüchen verhelfen. Es ist, als wenn wir ein Experiment am Rechner durchführen – aber eines, das wir in der Realität nicht durchführen könnten oder wollten.“

Stand: 27.01.2001