Den Anfang machten einfache Linien auf Papier – und auch die nur für wenige Auserwählte. Die ersten Supercomputer standen fast ausschließlich in den Laboratorien und Instituten der Regierungen. Von den 50er Jahren bis in die 70er hinein konnten nur sie sich Anschaffung und Unterhalt der extrem teuren Geräte überhaupt leisten.

Entsprechend wurden die ersten Großrechner auch primär für militärische Zwecke eingesetzt. Die Entwicklung von Kernwaffen, Berechnungen von Flugbahnen, die Entschlüsselung von Geheimcodes aber auch die ersten Wettervorhersagen standen im Vordergrund. Die grafische Ausgabe dieser schon sehr umfangreichen Berechnungen beschränkte sich allerdings auf einfache Linien oder bestenfalls zweidimensionale Schnittbilder.

Erst gegen Ende der 70er Jahre begannen auch die ersten Industrieunternehmen, Supercomputer einzusetzen. Automobilunternehmen simulierten die Fahreigenschaften ihrer neuen Modelle, Ölgesellschaften nutzten die Rechnerkapazität, um die Geologie von vielversprechenden Ölfeldern zu modellieren. Gleichzeitig wurden auch die ersten leistungsfähigeren Grafikprogramme entwickelt, mit denen auch Verläufe, Licht und Schatten und Farben abgebildet werden könnten. Doch die Rechnerkapazität reichte für größere Simulationen noch nicht aus. Komplexere Vorgänge konnten nur in geringer Auflösung – mit einem groben Datenraster – oder aber nur für kleine Teilaspekte des Ganzen modelliert werden.

Zehn Jahre später, Ende der 80er Jahre, hatte die Ära der Supercomputer fast in allen Branchen Einzug gehalten. Hunderte von Rechner arbeiteten in der Luft- und Raumfahrtindustrie, bei Energieversorgern, in der Elektronikbranche und bei Chemie- und Pharmakonzernen. Weitgehend leer gingen allerdings die öffentlichen Forschungseinrichtungen und Institute der Hochschulen aus. In den USA konnten sich nur wenige Universitäten den Kauf eines solchen Großrechners leisten. Für umfangreichere Simulationen und Modellrechnungen mussten amerikanische Wissenschaftler daher entweder mit den leistungsschwächeren Universitätsrechnern vorlieb nehmen, oder aber Rechenzeiten den Computerzentren der Regierung beantragen oder zu den damals bereits besser ausgestatteten Großforschungseinrichtungen in Europa reisen.

Astrophysiker der Universität von Illinois, berechneten 1982 beispielsweise auf dem Rechner ihres Computerzentrums – einem der schnellsten der damaligen Universitäten – wie Gas auf ein schwarzes Loch zuströmt. Der Rechner benötigte für die Gleichungen und die Berechnung der bildlichen Darstellung eine ganze Nacht. Das resultierende Modell erlaubte zwar schon erste Rückschlüsse auf die Geschwindigkeiten der Gasströme, war aber für weitergehende Aussagen über das Verhalten der Gase viel zu ungenau. Das aus Linien und Pfeilen bestehende Modell beruhte auf einem zu groben Raster.

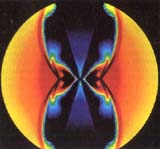

Im gleichen Jahr führten die Wissenschaftler daher eine Neuberechnung auf dem ersten europäischen Cray-1 Supercomputer am Max-Planck Institut für Physik in München durch. Der Computer schaffte die Simulation nicht nur innerhalb von einer Minute – 400 Mal schneller als der Universitätsrechner -, er zeigte auch erstmals die charakteristische achtförmige Druckwelle der in das Schwarze Loch einströmenden Gase.

Bis die ersten echten dreidimensionalen Modelle von Naturphänomenen möglich wurden, sollte es allerdings noch einige Jahre dauern. Erst Ende der 80er Anfang der 90er Jahre reichten Rechnerkapazität und Leistungsfähigkeit der Grafikprogramme aus, um nicht nur die mehrdimensionale Darstellung, sondern gleichzeitig auch eine genügend hohe Auflösung zu erreichen. Inzwischen sind 3-D Modelle in vielen Wissenschaftsbereichen zu fast unverzichtbaren Hilfsmitteln geworden.

Sie zeigen Zeitverläufe, modellieren Wolkenbewegungen oder chemische Reaktionen, erlauben wie ein Tomograph die Ansicht unterschiedlicher Ebenen – der erste Schritt zu einer echten virtuellen Realität ist gemacht. Besonders Klima- und Wetterforscher oder Geophysiker, aber auch Hirnforscher, Chemiker und Pharmazeuten nutzen bei der Erforschung von komplexen Naturphänomenen, der Entwicklung neuer Substanzen oder Technologien daher immer stärker die neuen Möglichkeiten.

Stand: 27.01.2001