Wissenschaftliche Praxis im Test: Was passiert, wenn 70 Forscherteams dieselben Datensätze auswerten? Ziehen sie aus ihren Analysen die gleichen Schlussfolgerungen? Das hat nun eine Studie anhand von Hirnscan-Datensätzen überprüft. Das Ergebnis: Trotz sehr ähnlicher Zwischenergebnisse gab es deutliche Unterschiede bei den Schlussfolgerungen, wie die Forscher im Fachmagazin „Nature“ berichten. Das unterstreiche die Bedeutung der Transparenz und Reproduzierbarkeit.

Die Wissenschaft lebt von der kritischen Selbstkontrolle. Dafür sorgen unter anderem das Gutachtersystem der „Peer Review“ bei den Fachjournalen, aber auch die Offenlegung von Methoden und Daten. Gleichzeitig werden Erkenntnisse und Hypothesen immer wieder anhand neuer Daten überprüft – und müssen gegebenenfalls erweitert oder korrigiert werden.

Diesen schrittweisen Erkenntnisprozess kann man bei der aktuellen Corona-Pandemie gut beobachten. So galt Covid-19 zunächst als Lungenkrankheit, inzwischen weiß man, dass das Virus fast alle Organe angreift. Zudem galten Kinder ursprünglich als weitgehend unempfindlich, jetzt gibt es Indizien für eine seltene Komplikation. Und viele weitere Fragen, darunter der Ursprung von SARS-CoV-2 oder der weitere Verlauf der Pandemie sind bislang offen.

108 Hirnscans, 70 Analyseteams

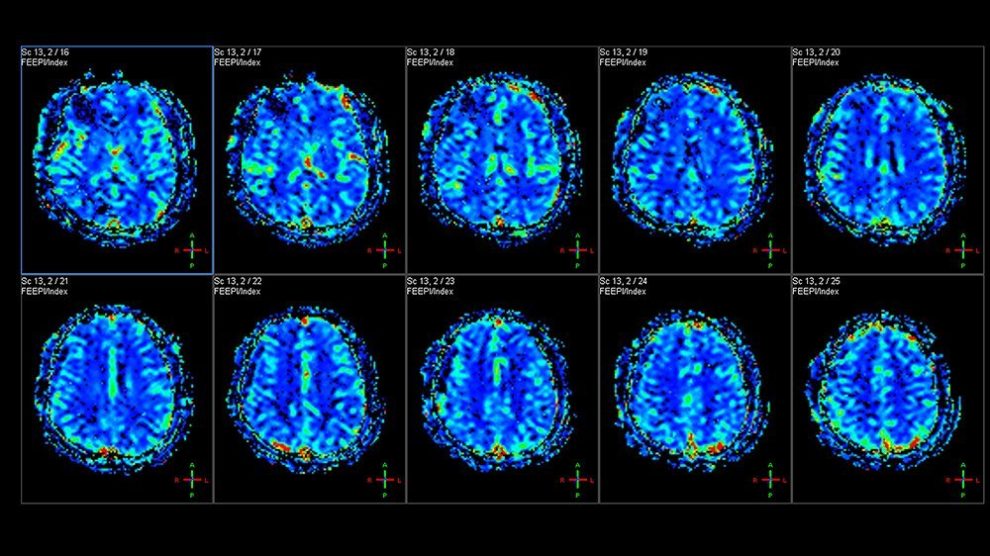

Doch wie einig sind sich Wissenschaftler, wenn sie auf Basis derselben Daten ihre Schlüsse ziehen sollen? Das haben nun Wissenschaftler unter Leitung von Tom Schonberg von der Universität Tel Aviv mit einem Experiment untersucht – dem größten dieser Art. Dafür wählten sie Hirnscans von 108 Versuchspersonen aus, die an einer neuropsychologischen Studie teilgenommen hatten. Diese mit funktioneller Magnetresonanztomographie (fMRT) gemachten Aufnahmen zeigten die Hirnaktivität der Probanden bei bestimmten Entscheidungen.

Diese 108 Datensätze verschickten Schonberg und sein Team dann an 70 Forscherteams in der ganzen Welt. Diese analysierten die Daten mit ihren jeweiligen Standard-Methoden und überprüften anhand der Ergebnisse neun vorgegebene Hypothesen. Als Endergebnis sollten sie die Hypothesen jeweils mit Ja oder Nein beantworten. Die Analyseteams hatten drei Monate Zeit, um die Daten auszuwerten.

Danach lieferten alle Teams Schonberg und seinen Kollegen ihre Resultate für die verschiedenen Hypothesen, ihre Zwischenergebnisse sowie detaillierte Informationen über ihr Vorgehen bei der Analyse.

Zwischenergebnisse ähnlich, Schlussfolgerungen nicht

Der Vergleich enthüllte: Bei den Zwischenergebnissen und den aufbereiteten Daten stimmten die Teams noch relativ gut überein. Auch ihre aus den Analysen erstellten Hirnaktivierungskarten waren sich noch weitgehend ähnlich, wie eine Metaanalyse ergab. Anders war dies jedoch bei den Schlussfolgerungen, die die Wissenschaftler aus ihren Auswertungen zogen: Bei fünf der neun Hypothesen gab es erhebliche Meinungsverschiedenheiten.

Eine mögliche Ursache vermuten die Forscher darin, dass hier komplexe Ergebnisse auf einfache Ja-Nein-Entscheidungen reduziert werden mussten. „Dieses spezielle Problem der Analyse betrifft alle Bereiche, in denen mit hochkomplexen Daten gearbeitet wird, die am Ende auf ein nacktes Ja-Nein-Resultat reduziert werden müssen“, erklärt Koautor Simon Eickhoff vom Forschungszentrum Jülich.

„Transparenz und Kooperation sind essentiell“

Damit belegt diese Studie, dass gerade die Analyse komplexer Daten auch davon abhängt, wer diese Daten in welcher Form auswertet. Trotz identischer Ausgangsdaten und festgelegter Fragestellungen kann es dabei offenbar vor allem bei der Interpretation der Daten zu erheblichen Abweichungen kommen.

Nach Ansicht der Forscher bestätigt dies die oft schon gängige Praxis, Rohdaten und Methoden offenzulegen – nur so können andere Teams das Vorgehen nachvollziehen. „In einer immer stärker datenbasierten und spezialisierten Wissenschaft sind Kooperation und Transparenz essentiell“, sagt Eickhoff. Die Tatsache, dass fast 200 Wissenschaftler bereit waren, zum Teil hunderte Stunden in dieses Experiment zu investieren, zeige aber auch, wie stark die Bereitschaft dazu sei.

„Dieser Prozess der Selbstreflexion und der kontinuierlichen Verbesserung der eigenen Methoden ist einzigartig und zeichnet die Wissenschaft aus“, betonen die Co-Autoren Michael Kirchler und Jürgen Huber von der Universität Innsbruck. (Nature, 2020; doi: 10.1038/s41586-020-2314-9)

Quelle: Forschungszentrum Jülich, Universität Innsbruck, Universität Wien