Weniger Fehler trotz Skalierung: Google-Forscher haben eine Methode zur Fehlerkorrektur bei Quantencomputern entwickelt, die eine wichtige Schwelle überschreitet. Ihr System fängt mehr Fehler ab, als beim Skalieren durch die zunehmende Zahl von Qubits entstehen, wie das Team in „Nature“ berichtet. Möglich wird dies durch die Kombination mehrerer Daten-Qubits zu logischen Einheiten und die Einfügung von zusätzlichen Mess-Qubits, die Fehler anzeigen.

Quantencomputer gelten als Rechner der Zukunft. Schon jetzt liefern sich Unternehmen wie IBM, Google und auch chinesische Forscher einen Wettbewerb um den größten und leistungsstärksten Qubit-Rechner. Das Problem jedoch: Quantenbits sind extrem fehleranfällig, schon kleine Störungen können sie aus ihrer Verschränkung und Überlagerung reißen – und mit der Zahl der Qubits steigt die Fehlerrate.

Ohne effiziente Fehlerkorrektursysteme sind Quantencomputer daher nicht auf die nötigen Leistungen skalierbar. Entsprechend intensiv arbeiten Wissenschaftler an Strategien, Qubitfehler zu messen und einzudämmen. Bisher schafften es diese Korrektursysteme aber nicht, mehr Fehler auszumerzen als durch die zusätzlichen Qubits dazukommen. „Die physikalischen Fehler haben bisher immer gewonnen“, erklären Hartmut Neven und Julian Kelly von Google Quantum AI.

Weniger Fehler trotz Skalierung

Doch das hat sich jetzt geändert: „Zum ersten Mal haben unsere Forscher experimentell demonstriert, dass man die Fehler bei zunehmender Qubitzahl reduzieren kann“, sagt Google-CEO Sundar Pichai. Der von Google Quantum AI entwickelte Prototyp zeigte bei logischen Schaltkreisen aus 17 physikalischen Qubits eine Fehlerrate von 3,038 Prozent pro Rechenzyklus, bei einem Schaltkreis aus 49 Qubits dagegen von 2,914 Prozent.

„Das erscheint zwar nicht viel, es ist aber das erste Mal, dass dieser experimentelle Meilenstein beim Skalieren von logischen Qubits erreicht wurde“, erklären die Forscher. Erstmals habe man die Schwelle überschritten, ab der die Quantenfehlerkorrektur eine steigende Leistung der Quantenrechner mit zunehmender Quantenbitzahl ermögliche. „Das ebnet den Weg hin zu logischen Fehlerraten, die für das Rechnen mit Quanten nötig sind.“

Logische Qubits machen Quantenrechnung robuster

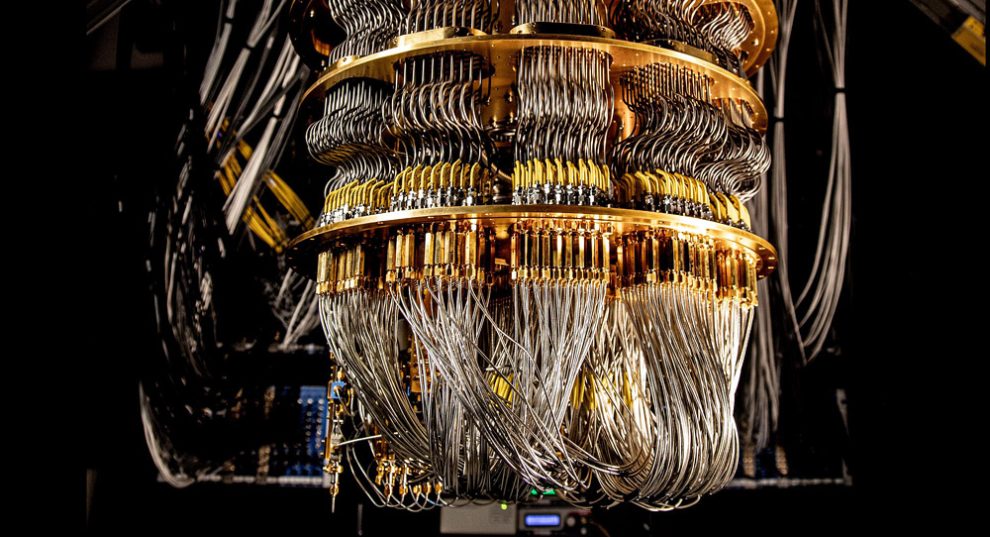

Möglich wurde dieser Fortschritt durch eine auf zwei Strategien beruhende Fehlerkorrektur. Das erste Grundprinzip ist das Rechnen mit logischen Qubits, der sogenannte Oberflächencode. Dabei werden mehrere physikalische Quantenbits – beim Google-Quantencomputer bestehen sie aus Quasiteilchen in einem supraleitenden Material – zu einer Recheneinheit zusammengefasst. Wenn nun eines der Qubits durch Störeinflüsse umkippt, bleiben noch genug andere Qubits übrig, um das Gesamtergebnis dieser Recheneinheit zu erhalten.

Neven und Kelly erklären dies am einer simplen Analogie: „Bob möchte Alice eine ‚1‘ als Bit über einen störanfälligen Kanal schicken. Um einen Verlust der Information zu vermeiden, schickt er stattdessen drei Bits: 111. Wenn nun einer umkippt, kann Alice noch immer die Mehrheitsverhältnisse der empfangenen Bits auslesen und so die Information bekommen.“ Je mehr Qubits man dabei zu einem logischen Qubit zusammenfasst, desto fehlerunempfindlicher ist das System.

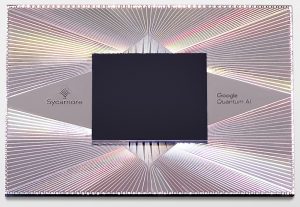

Für ihr Experiment nutzten die Wissenschaftler einen Sycamore-Quantencomputer mit 72 supraleitenden Qubits, in dem sie logische Recheneinheiten aus 17 und 49 physikalischen Qubits laufen ließen.

Mess-Qubits detektieren Fehler

Die zweite Strategie der Fehlerkorrektur umgeht ein grundlegendes Problem quantenphysikalischer Operationen: In dem Moment, indem man den Zustand eines Qubits ausliest, zerstört man seine Kohärenz und die Rechnung bricht ab. Um das Auftreten von Fehlern zu überwachen, ohne die Rechnung zu stören, ergänzten die Google-Forscher ihre Daten-Qubits durch spezielle Mess-Qubits. Diese liegen zwischen den rechnenden Bits des Quantencomputers und „belauschen“ ihren Zustand.

Der Trick dabei: „Diese Messungen verraten uns, ob die Qubits einer logischen Einheit noch das gleiche anzeigen oder ob sie sich durch einen Fehler unterscheiden“, erklären Neven und Kelly. „Dadurch zeigen sie Fehler an, ohne die einzelnen Daten-Qubits dafür auslesen zu müssen.“ Das Messsystem erkennt Bit- und Phasen-Fehler der Qubits und ermöglicht es, diese Fehler durch Auslesen des Mehrheitszustands der Daten-Qubits auszugleichen.

„Neue Ära der Quantenfehlerkorrektur“

Durch die Kombination dieser Systeme schafften es die Forscher erstmals, in einer größeren logischen Qubit-Einheit von 49 Qubits eine geringere Fehlerquote zu erzielen als in einer kleineren mit 17 Qubits. Der Unterschied in der Fehlerquote war zwar nur minimal, aber mit mehr als fünf Standardabweichungen signifikant. „Dieses Ergebnis zeigt, dass wir eine neue Ära der praktikablen Quantenfehlerkorrektur erreichen“, sagen Neven und Kelly. Allerdings räumen auch sie ein, dass dies erst der Anfang ist und dass noch einiges an Verbesserungen nötig ist.

Ander Quantenforscher sehen dies ähnlich: „Diese Arbeit demonstriert, dass sich die höhere Komplexität eines Systems mit mehr Qubits so weit unter Kontrolle bringen lässt, dass ein größerer Fehlerkorrekturcode die Information tatsächlich besser schützt als ein kleiner Code“, kommentiert Martin Ringbauer von der Universität Innsbruck. „Dies ist ein wichtiger erster Schritt, der zeigt, dass die zugrundeliegenden Fehlerquellen zwar noch deutlich unterdrückt werden müssen, aber dass sich der Aufwand lohnt.“

Entwicklung steht erst am Anfang

Laut Neven und Kelly ist es das selbstgesteckte Ziel von Google Quantum AI, die Fehlerrate von zurzeit einem Hundertstel bis Zehntausendstel auf künftig nur noch ein Millionstel pro Zyklus zu drücken. Dafür soll vor allem die Stabilität der supraleitenden Qubits weiter verbessert werden. Parallel zum Oberflächencode arbeiten die Forscher zudem an einer weiteren Methode der Fehlerkorrektur, dem bereits 2021 vorgestellten Wiederholungscode (Repetition Code). Dabei wechseln sich Daten- und Mess-Qubits in einer Kette ab. (Nature, 2023; doi: 10.1038/s41586-022-05434-1)

Quelle: Nature, Google Quantum AI