Digitale Computer sind heute allgegenwärtig: Die mit Bits und Bytes rechnenden Systeme stecken in Handys, PCs und Supercomputern, steuern Autos, Ampeln und unzählige andere technische Anlagen und bilden die Basis für künstliche Intelligenzen.

Optimierungen und das Problem des Handlungsreisenden

Doch trotz all dieser Fortschritte stößt das digitale Rechnen an Grenzen – und ist längst nicht immer das ideale Werkzeug zur Lösung eines Rechenproblems. Dies gilt unter anderem für Optimierungsprobleme, wie sie in vielen Industrie und Branchen wie der Logistik und dem Transport, im Finanzwesen oder der Medizin vorkommen. Der Grund: Je mehr Faktoren in eine optimale Kombination zu bringen sind, desto schneller wächst die Zahl der zu bewertenden Kombinationen – der Rechenaufwand wächst exponentiell.

Ein klassisches Beispiel für ein solches Optimierungsproblem ist das altbekannte Problem des Handlungsreisenden, der eine bestimmte Zahl von Städten auf seiner Reise besuchen muss und nun dafür die effizienteste Route sucht. Dabei darf er jede Stadt nur einmal besuchen. „Dieses Rundreiseproblem klingt trivial, ist aber eine harte Nuss“, erklärt der Mathematiker Jens Vygen von der Universität Bonn, der an mathematischen Lösungen dieses Problems forscht. Schon bei 15 Städten existieren 43 Milliarden mögliche Reiserouten, bei 61 Städten gäbe es mehr Möglichkeiten als Atome im gesamten Universum.

Selbst der leistungsstärkste Supercomputer bräuchte Millionen Jahre für die Lösung dieses Problems, daher gilt es unter Informatikern auch als „NP-unvollständig“ – als nicht vollständig und effizient mit einem Algorithmus zu lösen.

Je komplexer, desto mehr Schritte

Doch warum tun sich digitale Computer so schwer mit solchen Optimierungsproblemen? Der Grund ist die Art, wie digitale Computer arbeiten. Damit sie eine Aufgabe lösen können, benötigen sie zunächst einen Algorithmus, der die Arbeit in eine Reihe von Einzelschritten herunterbricht. Diese wiederum müssen so angelegt sein, dass ihr Ergebnis über diskrete Ja-Nein-Entscheidungen – Nullen und Einsen – erreicht wird. „Es ist jedoch extrem schwierig, umfangreichere Optimierungsprobleme der realen Welt in binäre Abstraktionen zu übersetzen“, sagt Hitesh Ballani vom Microsoft Research Lab im englischen Cambridge.

Je komplexer ein Problem ist, desto mehr Einzelschritte benötigt ein digitaler Computer. Dies gilt vor allem dann, wenn der Rechner eine Aufgabe bewältigen soll, die nicht-diskrete Parameter enthält – beispielsweise die von sich kontinuierlich verändernden Kräften beeinflusste Geschwindigkeit und Flugbahn eines durch die Luft fliegenden Geschosses. „Was man mit einem digitalen Computer macht ist, dass man ein eigentlich kontinuierliches Problem in lauter kleine Scheibchen zerhackt – ähnlich wie beim Berechnen eines Integrals in der Schule“, sagt der deutsche Informatiker Bernd Ulmann, Gründer des Analogcomputer-Startups anabrid.

Zeitraubendes Hin- und Her

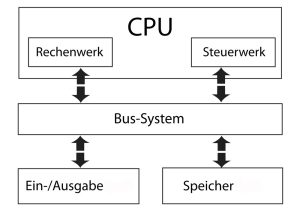

Hinzu kommt: Weil ein zentraler Algorithmus alle Rechenprozesse steuert, muss der Computer immer wieder Informationen zwischen Speicher und Prozessor hin- und herbewegen: „Im Prinzip führt jeder Prozessor dabei eine Abfolge von Instruktionen aus, die er aus dem Speicher-Untersystem auslesen und dekodieren muss, dann muss er die Operanden holen, die geforderte Operation ausführen und die Ergebnisse wieder abspeichern und so weiter“, erklärt Ulmann. Je nach Entfernung der Bauteile voneinander kann allein dieser ständige Datentransfer das Drei- und Zehntausendfache der für die eigentliche Rechenoperation nötigen Energie verbrauchen.

Aufgrund all dieser funktionellen und strukturellen Grundlagen verbrauchen moderne Hochleistungsrechner viel Strom – und sind keineswegs immer die schnellsten. Zwar durchbrachen die ersten Supercomputer im Jahr 2022 die Rekordmarke von mehr als einer Trillion Gleitkommaberechnungen pro Sekunde. Für komplexe Simulationen und Modelle benötigen jedoch selbst solche Superrechner oft Wochen oder Monate der Rechenzeit.

Grenzen auch für die künstliche Intelligenz

Die Nachteile des digitalen Rechnens zeigen sich auch in ihrem modernsten und am schnellsten wachsenden Zweig: der künstlichen Intelligenz. Allein um das KI-System ChatGPT am Laufen zu halten und die Anfragen der Nutzer zu beantworten, benötigt OpenAI jüngsten Schätzungen zufolge rund 564 Megawattstunden Strom pro Tag – Tendenz steigend. Denn je umfangreicher und leistungsfähiger die KI-Modelle werden, desto mehr Rechenschritte sind nötig, um die künstliche Intelligenz zu trainieren und eine Aufgabe zu lösen. Schon jetzt weckt das rasante Wachstum der KI-Branche die Sorge, dass die nötigen Rechenzentren bald mehr Energie verschlingen als ganze Länder.

„Das klassische Computing stößt an seine Grenzen. Wir brauchen frische Ideen für das Hochleistungsrechnen – und auch für das energieeffizientere Rechnen“, sagt Ulmann. Kein Wunder, dass inzwischen selbst große Player der KI- und Computerindustrie nach Alternativen jenseits des rein Digitalen suchen. Doch wie könnten diese Alternativen aussehen?