In der chemischen Analytik, in der Wetter- und Erdbebenvorhersage, sogar in den Rechts- und Wirtschaftswissenschaften waren neuronale Netze lange Zeit in Mode: Mit ihrer Hilfe kann man riesige Datenmengen nach verborgenen Zusammenhängen durchforsten, die der puristischen, klassischen Analyse verborgen geblieben wären. Heute ist ihr Stern jedoch ein wenig im Sinken begriffen. Präzisere, aber in der dahinter stehenden Theorie ungleich anspruchsvollere Analysemethoden und die Leistungsfähigkeit schneller Rechner haben den Softwareneuronen den Rang abgelaufen.

Denn der Segen der neuronalen Netze ist zugleich ihr Fluch: Mit ihnen lässt sich zwar prinzipiell der Verlauf jeder beliebigen mathematischen Funktion annähern. Leider verrichten sie ihren Job in der Praxis aber nur mit mäßiger Genauigkeit. Um dies zu verstehen, reicht ein Blick auf ihre Funktionsweise. So geht ihr Arbeitsprinzip auf eine Idee des russischen Mathematikers Andreij Nikolajewitsch Kolmogorow zurück, eines der bedeutendsten mathematischen Köpfe des 20. Jahrhunderts.

Kolmogorow machte sich im Jahr 1948 noch recht abstrakte Gedanken über ein „Black-Box-System“, das jeden wie auch immer gearteten Input auf logische Weise mit einem passenden Output verbinden kann – wie eine Parabelfunktion ein x mit einem y verbindet. Nur eben viel universeller. Am einfachsten lässt sich der „universale Approximator neuronales Netz“ tatsächlich durch einen Vergleich mit echten Nervenzellen verstehen.

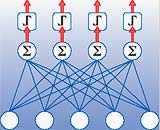

Bekanntlich besteht das Gehirn aus einer Vielzahl einander sehr ähnlicher Zellen (Neuronen), die über gewisse Leitungen mit anderen, gleichartigen verschaltet sind, die wiederum Kontakt zu weiteren haben. In der Natur kann eine einzelne Nervenzelle mit tausenden anderer verbunden sein. Wenn ein solches Neuron dann von seinen Nachbarn mit Signalen bestürmt wird, macht es zunächst nichts weiter, als diese eingehenden Signale zu summieren. Erreicht die Summe aller Anrufe zusammengenommen einen gewissen Schwellenwert, entscheidet sich das Neuron, seinerseits ein Signal zu feuern, das nun zur Erregung der Nachbarzellen beiträgt.