Verstehst du, was ich sage? Unser Gehirn verarbeitet Sprache offenbar anders als gedacht. Denn wie eine Studie nahelegt, findet die Spracherkennung nicht erst in der Großhirnrinde statt. Stattdessen beginnt die Verarbeitung der Hörinformation bereits in den Leitungsbahnen auf dem Weg dorthin. Diese Erkenntnis könnte künftig bei der Weiterentwicklung von Sprachassistenten helfen – aber auch das Verständnis von Legasthenie verbessern.

Ob Siri, Alexa oder der Google Assistant: Sprachassistenten sind aus unserem Alltag heute kaum noch wegzudenken. Sie schalten Geräte ein, präsentieren uns die aktuellen Nachrichten und informieren über die Wettervorhersage. Dass diese Systeme unsere Sprache so gut erkennen können, haben wir Fortschritten im Bereich der künstlichen Intelligenz zu verdanken. Durch den Einsatz künstlicher neuronaler Netze ist die Spracherkennung in den vergangenen Jahren immer besser geworden.

So gut aber wie das natürliche Vorbild sind diese Systeme noch lange nicht. „Das menschliche Gehirn funktioniert viel besser als die computerbasierte Sprachverarbeitung und das wird wohl auch noch eine ganze Zeit lang so bleiben. Denn die genauen Abläufe der Sprachverarbeitung im Gehirn sind bisher noch weitestgehend unbekannt“, erklärt Katharina von Kriegstein von der Technischen Universität Dresden.

Was wird gesagt?

Wo zum Beispiel beginnt die Verarbeitung von Sprache überhaupt? Bisher galten in diesem Zusammenhang vor allem die Sprachzentren der Großhirnrinde als entscheidende Orte des Geschehens. Doch von Kriegstein und ihre Kollegen um Erstautor Paul Mihai haben nun Hinweise darauf gefunden, dass die Spracherkennung schon viel früher beginnt: nämlich bereits auf dem Weg zum Cortex.

Für ihre Studie untersuchten die Wissenschaftler, welche Regionen im Gehirn bei der Sprachverarbeitung besonders aktiv sind. 33 Versuchspersonen bekamen dafür kurze Sprachaufnahmen von unterschiedlichen Sprechern zu hören. Dabei erhielten sie eine von zwei Instruktionen: Entweder sie sollten herausfinden, ob die gehörte Stimme dieselbe war wie die vorherige, oder sie sollten die gehörten Silben vergleichen.

Linke Hörbahn im Fokus

Es ging bei der ersten Aufgabe demnach darum, den Sprecher zu identifizieren, bei der anderen hingegen stand der Inhalt des Gesprochenen im Fokus – es musste Sprache verarbeitet werden. Würde sich die Gehirnaktivität der Probanden je nach Aufgabe unterscheiden? Dies beobachtete das Forscherteam mithilfe der Magnetresonanztomographie (MRT).

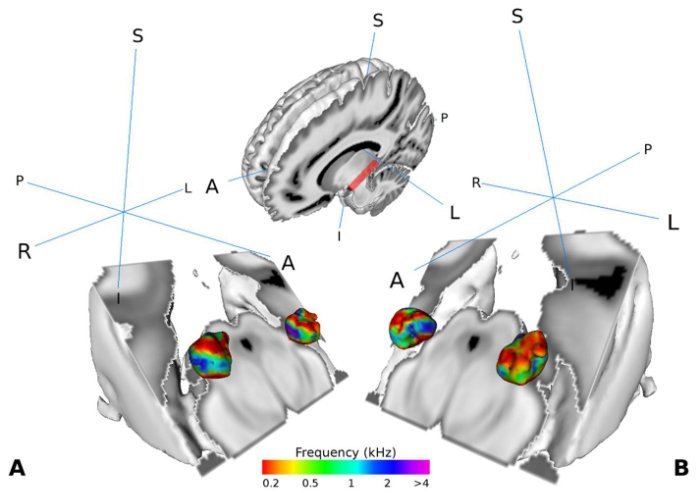

Die Ergebnisse zeigten: Wenn die Studienteilnehmer die Spracherkennungsaufgabe durchführten, war überraschenderweise auch eine Struktur in der linken Hörbahn, der sogenannte mediale Kniehöcker, besonders aktiv. Die Aktivität dieser Region war dabei umso höher, je besser die Probanden beim Erkennen der Silben waren.

Verarbeitung beginnt früher

Nach Ansicht der Wissenschaftler spricht dies dafür, dass die Verarbeitung der Hörinformation bereits in den Leitungsbahnen vom Ohr zur Großhirnrinde beginnt und nicht erst, wenn diese den Cortex erreichen. „Wir haben schon seit einiger Zeit erste Hinweise darauf, dass die Hörbahnen spezialisierter auf Sprache sind als bisher angenommen. Diese Studie zeigt nun, dass dies tatsächlich der Fall ist“, kommentiert von Kriegstein.

„Ein Großteil der Sprachforschung konzentriert sich auf Strukturen in der Großhirnrinde. Doch auch den Beitrag subkortikaler Strukturen für die Sprachwahrnehmung zu untersuchen, ist für unser Verständnis der menschlichen Spracherkennung enorm wichtig. Diese Untersuchung bringt uns einen entscheidenden Schritt in diese Richtung“, erklären die Forscher.

Bedeutung für Lese-Rechtschreib-Störung?

In Zukunft könnten die neuen Erkenntnisse nicht nur bei der Weiterentwicklung computerbasierter Spracherkennungssysteme helfen. Womöglich haben die Ergebnisse auch Relevanz für einige Symptome der Lese-Rechtschreib-Störung, wie die Wissenschaftler berichten. So sei bekannt, dass der linke mediale Kniehöcker bei Betroffenen anders funktioniert als bei Personen ohne diese Störung.

Die Spezialisierung des linken medialen Kniehöckers auf Sprache könnte nach Ansicht des Teams unter anderem erklären, warum Legasthenie-Patienten häufig Schwierigkeiten haben, Sprachsignale in geräuschvollen Umgebungen zu verstehen. Weitere Studien sollen diesen Zusammenhang künftig näher untersuchen. (eLife, 2019; doi: 10.7554/eLife.44837)

Quelle: Technische Universität Dresden