Musikalisches Gedankenlesen: Allein mit Hilfe von Hirnscans und EEG-Daten lässt sich entschlüsseln, welche Musik eine Testperson gerade hört, wie ein Experiment belegt. Dabei identifizierte eine entsprechend trainierte künstliche Intelligenz anhand der nichtinvasiv aufgezeichneten neuronalen Signale das richtige Musikstück mit einer Trefferquote von 71,8 Prozent. Die Ergebnisse könnten ein erster Schritt auf dem Weg sein, auch Sprache nichtinvasiv aus Hirnwellen auszulesen.

Musik ist tief in unserer Natur verwurzelt. Hören wir vertraute Klänge, identifiziert unser Gehirn sie innerhalb von Sekundenbruchteilen. Hirnstrommessungen zeigen, dass Musik ein wahres Feuerwerk an Signalen auslösen kann, einhergehend mit starken Emotionen und Gänsehautgefühl. Verschiedene Forschungsteams haben sich bereits damit beschäftigt, was die Hirnströme beim Musikhören verraten können – etwa über die Emotionen der Probanden oder über die Musik selbst.

Kombination aus EEG und fMRT

Ian Daly von der School of Computer Science and Electronic Engineering der Universität Essex in Großbritannien hat nun gezeigt, dass sich aus den Hirnströmen ablesen lässt, welche Musik eine Person gerade hört. Während frühere Studien beispielsweise zum Auslesen von Sprache aus der Hirnaktivität, dafür oft auf invasive Methoden wie Elektrokortikografie (EKoG) zurückgegriffen haben, für die Elektroden im Schädel platziert werden, nutzte Daly Daten aus nicht-invasiven Elektroenzephalografie-Messungen (EEG).

Um die Genauigkeit der Vorhersagen zu erhöhen, kombinierte Daly die EEG-Daten mit funktionellen Magnetresonanztomografie-Messungen (fMRT), die den Blutfluss im Gehirn zeigen und so Aufschluss darüber geben, welche Hirnregionen beim Hören von Musik bei der jeweiligen Person besonders aktiv sind. Diese Informationen nutzte der Forscher dazu, um jeweils genau jene EEG-Daten für die weitere Analyse auszuwählen, die diesen Bereichen entsprachen.

Musik aus Hirnströmen rekonstruiert

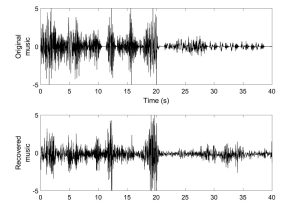

Die Daten stammten aus einer früheren Studie, bei der der ursprüngliche Fokus auf den Emotionen der Musikhörenden lag. Die 18 in die Analyse einbezogenen Testpersonen hatten dabei 36 kurze Stücke von Klaviermusik gehört, während ihre Hirnaktivität per fMRT und EEG aufgezeichnet wurde. Daly trainierte nun ein Deep-Learning-Modell darauf, die Muster im EEG so zu dekodieren, dass es das jeweilige Musikstück, das die Testperson während der Messung gehört hatte, rekonstruieren konnte.

Tatsächlich war das Modell in der Lage, Tempo, Rhythmus und Amplitude der Musik in Teilen nachzuvollziehen. Dabei war die Ähnlichkeit zu den Originalmusikstücken hoch genug, dass der Algorithmus mit einer Trefferquote von 71,8 Prozent vorhersagen konnte, welches der 36 Musikstücke die Person gehört hatte.

Individuelle Unterschiede

Um die Ergebnisse zu validieren, nutze Daly eine unabhängige Stichprobe von 19 weiteren Probanden, die ebenfalls die entsprechenden Musikstücke gehört hatten. Da von diesen Personen nur EEG-Daten, jedoch keine fMRT-Daten vorlagen, nutzte Daly zur Bestimmung der relevanten EEG-Daten die Informationen der ersten Stichprobe.

„Selbst wenn personenspezifische fMRT-Daten fehlten, waren wir in der Lage, die gehörte Musik allein anhand der EEG-Daten zu identifizieren“, berichtet Daly. Allerdings weist er darauf hin, dass sich die Lokalisation der relevanten Hirnreaktionen auf Musik von Mensch zu Mensch unterscheidet. Entsprechend war das Modell, wenn es nicht mit personenspezifischen fMRT-Daten angepasst werden konnte, ungenauer und erreichte nur eine Trefferquote von 59,2 Prozent.

Fernziel: Sprache erkennen

Daly sieht sein Modell als einen ersten Schritt auf dem Weg zu größeren Zielen. „Diese Methode hat viele potenzielle Anwendungen“, sagt er. „Wir haben gezeigt, dass wir Musik entschlüsseln können, was darauf hindeutet, dass wir eines Tages in der Lage sein könnten, Sprache aus dem Gehirn zu entschlüsseln.“ Zwar ist dies in Ansätzen schon jetzt möglich, wie Experimente zeigen. Bisher funktioniert dies aber nur mit invasiver Technik wie Elektroden im Gehirn.

Für Menschen mit Locked-In-Syndrom, die aufgrund von Lähmungen keine Möglichkeit haben, mit anderen Menschen zu kommunizieren, könnte dies ein Tor zur Außenwelt eröffnen. „Natürlich ist dies noch ein weiter Weg, aber wir hoffen, dass wir, wenn wir eines Tages die Sprache erfolgreich entschlüsseln können, dies nutzen können, um Kommunikationshilfen zu bauen“, sagt Daly. (Scientific Reports, 2023, doi: 10.1038/s41598-022-27361-x)

Quelle: University of Essex