Taktierend wie ein Mensch? Ob und wie sehr sich künstliche Intelligenz in Verhalten und Persönlichkeit von uns Menschen unterscheidet, haben Forscher nun mit einer Reihe von psychologischen Turing-Tests untersucht. Das Ergebnis: GPT-3.5 und GPT-4 reagieren in den meisten Tests ähnlich wie wir Menschen, tendenziell verhalten sie sich aber etwas altruistischer und fairer als wir. Dies spricht gegen Befürchtungen einer „dunklen“ KI-Persönlichkeit – zumindest bei diesen KI-Systemen.

Generative KI-Systeme wie ChatGPT haben die künstliche Intelligenz revolutioniert und kommen in immer mehr Bereichen zum Einsatz. Das wirft jedoch die Frage auf, ob wir diesen KI-Systemen trauen können. Erste Studien zeigten beispielsweise, dass KI-Systeme zwar selbst anspruchsvolle Fachprüfungen bestehen und sogar Kreativität zeigen. Aber selbst GPT-4 lässt sich in seinen Antworten und Entscheidungen überraschend leicht verunsichern und in moralischen Dilemmata entscheiden einige künstliche Intelligenzen rigider als wir Menschen.

Gefangenendilemma und Co als Turing-Test

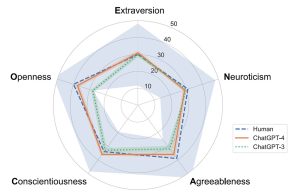

Einen weiteren Aspekt der KI-„Persönlichkeit“ haben nun Forscher um Qiaozhu Mei von der University of Michigan untersucht. Sie wollten wissen, ob künstliche Intelligenz ähnlichen psychologischen Strategien und Prinzipien folgt wie ein Mensch. „Dafür führen wir einen psychologischen Turing-Test durch und untersuchen, wie sich Chatbots in einer Suite von klassischen Spieltests verhalten, die den Persönlichkeitstyp sowie Fairness, Kooperation, Altruismus, Vertrauen und weitere Merkmale analysieren“, erklärt das Team.

Für ihren Turing-Test ließen die Forscher GPT-3.5 und GPT-4 eine Reihe gängiger Spieltests durchführen, in denen sich die KI jeweils entscheiden muss, ob und wie viel Geld sie mit einem oder mehreren Mitspielern teilt. Bekannte Varianten dieser Tests sind das Gefangenendilemma, das Diktatorspiel oder auch das Ultimatumspiel. Zusätzlich untersuchte das Team auch, ob Framing und Kontext die Entscheidungen einer KI beeinflussen und ob die Maschinenhirne ihr Verhalten aufgrund vorangehender Erfahrungen in solchen Spielen verändern. Beides ist bei uns Menschen der Fall.