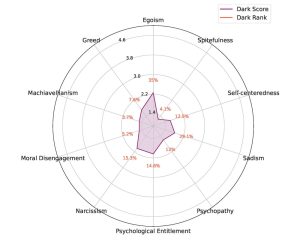

Linke Tendenzen: Die Antworten der künstlichen Intelligenz ChatGPT sind politisch nicht neutral, sondern eher libertär-progressiv, wie eine Studie enthüllt. Das KI-System schnitt in zwei umfangreichen Tests der politischen Einstellung durchgängig im progressiven, linken Bereich ab. Dazu passen die Ergebnisse der generativen künstlichen Intelligenz in zwei gängigen psychologischen Persönlichkeitstests. Immerhin scheinen die dunkleren Seiten der Persönlichkeit bei ChatGPT nur wenig ausgeprägt, wie Forschende ermittelten.

Die auf einem großen Sprachmodell (LLM) basierende künstliche Intelligenz ChatGPT hat demonstriert, wie fortgeschritten neue selbstlernende KI-Systeme inzwischen sind. Der Chatbot erstellt Texte aller Art, kann Programme schreiben und täuscht sogar wissenschaftliche Fachgutachter. Zudem hat die generative KI bereits Mediziner-Tests, Jura-Examen und andere Prüfungen erfolgreich absolviert. Wegen dieser Leistungen und der geringen Transparenz der dahinterstehenden Prozesse haben einige Wissenschaftler bereits ein Moratorium für die weitere KI-Entwicklung gefordert.

Doch ChatGPT und Co haben eine entscheidende Schwachstelle: Sie sind nur so gut wie die Daten, mit denen sie trainiert wurden. Finden sich in den meist aus dem Internet zusammengestellten Trainingsdaten Fake News, Vorurteile und diskriminierende Aussagen, dann werden sie von den KI-Systemen reproduziert. Zwar versuchen OpenAI und andere Entwickler solcher generativen KI, dies durch eine zusätzliche, von Menschen kontrollierte Lernphase einzuschränken. Sie räumen aber ein, dass die Antworten ihrer KI Falschinformationen oder Vorurteile enthalten können.

Wie politisch voreingenommen ist ChatGPT?

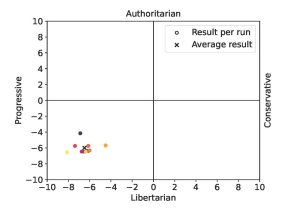

Das wirft eine weitere Frage auf: Sind die Antworten von ChatGPT zu politischen Themen neutral? „ChatGPT ist zwar Open Access, aber nicht Open Source“, erklären Jerôme Rutinowski von der Technischen Universität Dortmund und seine Kollegen. „Daher können Nutzer nur raten, mit welchen Daten er trainiert wurde und warum er sich so verhält, wie er es tut.“ Um die politische Ausgewogenheit des KI-System zu untersuchen, unterzogen die Forschenden die auf GPT 3.5 laufende Version des Chatbots zwei gängigen Tests zur politischen Einstellung, die 62 beziehungsweise über 100 Fragen umfassen.