Mathe statt Spezialtechnik: Forscher haben eine Methode entwickelt, mit der sich animierte Gesichter in Filmen oder Ciomputespielen einfacher und realistischer erzeugen lassen. Statt aufwändiger Spezialkameras und Nachbearbeitung per Hand, genügen nun normale Filmaufnahmen als Vorlage, den Rest erledigt ein mathematisches Modell. Es erzeugt automatisch die gewünschten Mienen und Gesichts bewegungen – und das äußerst realistisch.

Als Brad Pitt in dem Kinofilm „Der seltsame Fall des Benjamin Button“ sein Leben rückwärts vom Greis zum Kleinkind lebt, ist nicht nur viel Make-up im Spiel. Jede Szene wurde am Computer nachbearbeitet, um Pitts Gesicht realistisch und altersgemäß zu animieren. „In den großen Filmstudios wird an manchen Fünf-Sekunden-Szenen mehrere Wochen lang gearbeitet, um das Aussehen eines Schauspielers und die Proportionen von Gesicht und Körper fotorealistisch wiederzugeben“, erklärt Christian Theobalt vom Saarbrücker Max-Planck-Institut für Informatik.

Modell errechnet nötige Parameter

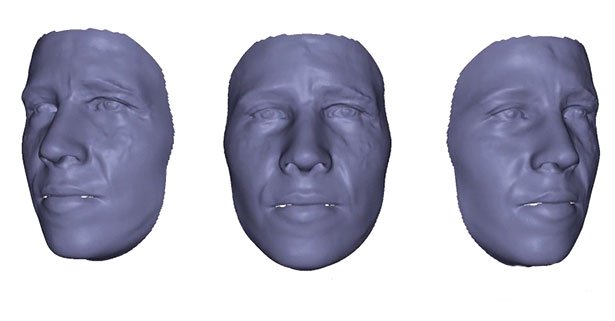

Um ein Gesicht mit allen Details zu animieren, benötigt man ein genaues dreidimensionales Gesichtsmodell, im Fachjargon face rig genannt. Darin werden die Lichtverhältnisse und Reflexionen der Filmszene eingepasst. Theobalt und seine Kollegen haben nun ein Verfahren entwickelt, das die aufwändige Entwicklung solcher Modelle überflüssig macht – es genügen Gesichts-Aufnahmen einer normalen Standardkamera. Den Rest erledigt ein mathematisches Modell.

„Wir schätzen dabei mit mathematischen Methoden die Parameter ab, die man benötigt, um alle Details des Gesichtsmodells zu erfassen“, erkärt Theobalt. Dazu gehören nicht nur die Gesichtsgeometrie, sondern auch die Reflexionseigenschaften der Oberflächen und die Szenenbeleuchtung. Diese Angaben reichten aus, um mit dem neuen Verfahren ein individuelles Gesicht am Rechner realitätsgetreu zu rekonstruieren und es zum Beispiel mit Lachfältchen auf natürliche Weise zu animieren.

Normale Fimaufnahmen reichen

„Es funktioniert als Gesichtsmodell wie ein vollständiges face rig, dem wir allein über mathematische Verfahren unterschiedliche Gesichtsausdrücke verpassen können“, sagt Theobalt. Der Algorithmus seines Teams enthält bereits die Information über unterschiedliche Emotionen. „Wir können also am Computer entscheiden, ob der Schauspieler oder Avatar eher fröhlich oder nachdenklich ausschauen soll und können ihm eine detailreiche Mimik geben, die es so vorher in den Filmaufnahmen nicht gab“ erklärt der Forscher.

„Uns reicht auch eine alte Filmaufnahme, in der zum Beispiel ein Dialog zu sehen ist, um damit ein Gesicht präzise zu modellieren und zu animieren“, so der Informatiker. Mit dem rekonstruierten Modell könne man auch die Mundbewegungen eines Schauspielers in einem synchronisierten Film an die neue Sprache anpassen. Spezialbeleuchtung und Mehrkamerasysteme wie bisher für genaue Facerigs notwendig, sind dabei überflüssig.

Das Verfahren ist aber nicht nur für die Filmindustrie interessant, sondern kann auch dabei helfen, Avataren in der virtuellen Welt, dem persönlichen Assistenten im Netz oder virtuellen Gesprächspartnern in zukünftigen Telepräsenzanwendungen ein realistisches persönliches Antlitz zu geben. „Unser Technik kann dafür sorgen, dass sich die Menschen bei ihrer Kommunikation mit und durch Avatare wohler fühlen“, sagt Theobalt.

(Universität des Saarlandes, 10.03.2016 – NPO)