Künstliche Intelligenz als Bildauswerter

Das hat sich nun geändert. Christopher Metzler von der Stanford University und seine Kollegen haben eine Technik entwickelt, die verblüffend scharfe, hochaufgelöste Bilder liefert – und dies bei Tageslicht und mit einer normalen Digitalkamera als Sensor. Möglich wurde dies, weil die Forscher zunächst ein neues physikalisches Modell der Lichtstreuung und des Störrauschens entwickelten und dann ein komplexes neuronales Netzwerk auf Basis dieses Modells trainierten.

„Deep Learning ist ein leistungsfähiges Werkzeug um Bildgebungsprobleme computergestützt zu lösen“, erklären die Forscher. „Aber es benötigt dafür normalerweise immense Mengen an Trainingsdaten.“ Beim „Eckenblick“ jedoch ist es sehr aufwändig, diese großen Mengen an Trainingsbildern zu erzeugen. Deshalb nutzten Metzler und sein Team ihr Model, um diese Trainingsdaten künstlich zu generieren.

Doch würde das ausreichen, um auch echte „Eckenbilder“ erfolgreich auszuwerten?

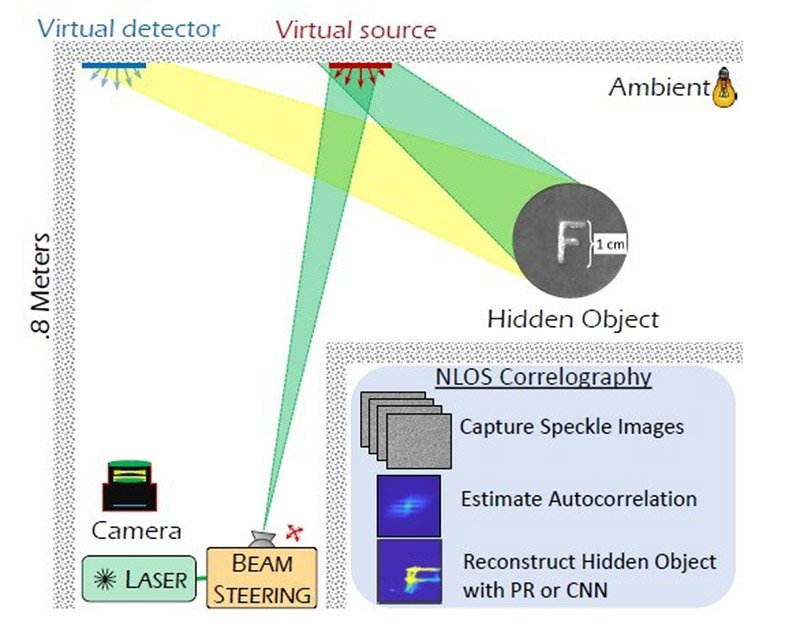

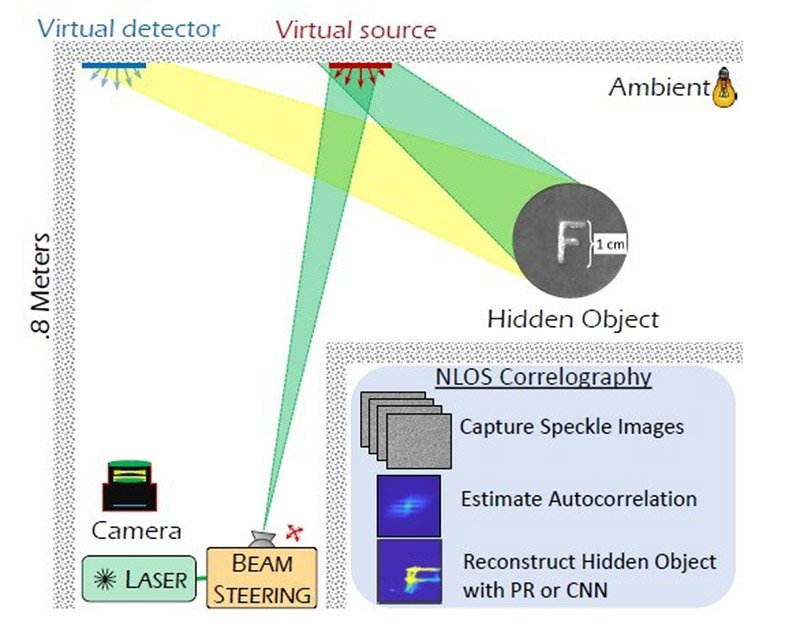

Die Versuchsanordnung für den Test des "Eckenblick"-Systems. © Prasanna Rangarajan/ Southern Method University

Auflösung von 300 Mikrometern

Um das zu testen, konstruierten die Forscher eine Testkammer, in der als verstecktes Objekt das Bild eines Buchstabens von einem Zentimeter Höhe stand. Einen Meter davon entfernt lag eine Wand, die als Reflektionsfläche diente. Diese strahlten die Wissenschaftler nun im 45-Grad-Winkel mit einem handelsüblichen Laser an. Gleichzeitig richteten sie die Digitalkamera auf die Wand, um das reflektierte Licht zu fotografieren. Die Bilddaten bekam dann das neuronale Netzwerk zur Auswertung.

Das Ergebnis: Dem KI-System gelang es, die um die Ecke liegenden Buchstaben sichtbar zu machen – und dies überraschend scharf. „Unser System rekonstruierte erfolgreich die Form kleiner, versteckter Objekte in einem Meter Abstand, indem es nur zwei Fotos einer gängigen Kamera mit 1/8 Sekunden Belichtungszeit nutzte“, berichten Metzler und seine Kollegen. Die Auflösung des Systems erreichte dabei selbst bei relativ hellem Umgebungslicht rund 300 Mikrometer.

„Verglichen mit anderen Ansätzen für die Non-Line-of-Sight-Bildgebung ist unser Deep Learning Algorithmus weit robuster gegenüber Störrauschen und kann daher mit viel kürzeren Belichtungszeiten arbeiten“, erklärt Koautor Prasanna Rangarajan from Southern Methodist University.

Nützlich für das autonome Fahren

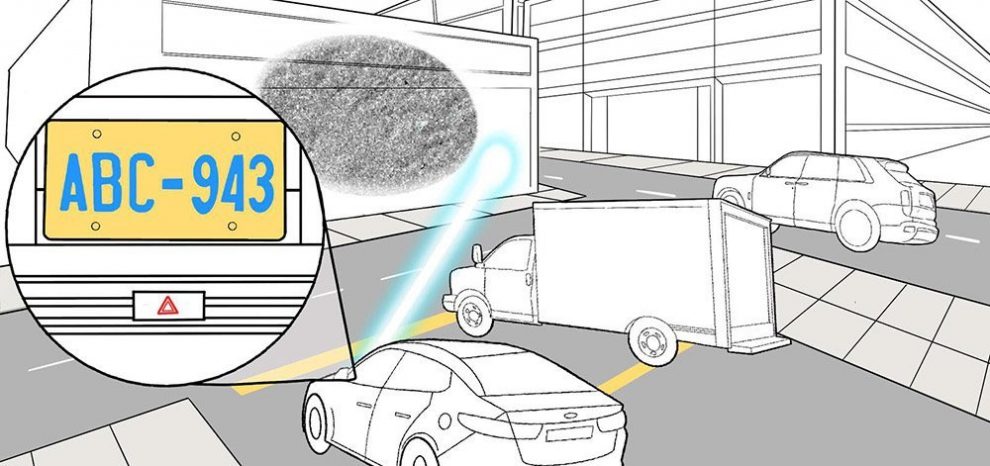

„Dies ist ein bedeutender Schritt in Richtung einer Non-Line-of-Sight-Bildgebung in Echtzeit und mit hoher Auflösung“, konstatieren die Wissenschaftler. Mit solchen Systemen könnte man beispielweise das Nummernschild eines um die Ecke parkenden Autos sichtbar machen oder an einer Kreuzung versteckte Fußgänger auf Kollisionskurs frühzeitig ausmachen. Ein solcher Eckenblick“ könnte daher vor allem für künftige autonome Fahrzeuge von großem Nutzen sein.

„Non-Line-of-Sight“-Bildgebung hat wichtige Anwendungen in der Navigation, der Robotik, der medizinischen Bildgebung und auch der Verteidigung“, sagt Koautor Felix Heide von der Princeton University. „Unsere Arbeit bahnt diesen Systemen den Weg hin zu einer ganzen Bandbreite solcher Anwendungen.“ (Optica, 2020; doi: 10.1364/OPTICA.374026)

Quelle: The Optical Society

17. Januar 2020

- Nadja Podbregar