Neues Level erreicht: Forschende haben ein KI-System entwickelt, das gelernte Konzepte erstmals ähnlich gut verallgemeinern kann wie wir Menschen. Bisherige künstliche Intelligenzen hatten Probleme, wenn es darum ging, bekannte Komponenten neu zu kombinieren und dabei logische Verknüpfungen zu beachten. Das jetzt in „Nature“ vorgestellte KI-System auf Basis eines neuronalen Netzes zeigt diese Fähigkeit jedoch – das ist ein weiterer Schritt in der Nachahmung der menschlichen Kognition.

Künstliche Intelligenzen wie ChatGPT, Alphafold und Co. sind zu beeindruckenden Leistungen in der Lage. Sie können Texte und Bilder erstellen, Krankheiten voraussagen, Grundprinzipien der Wissenschaft herleiten und sogar Kreativität zeigen. Doch bisher weisen sie ein entscheidendes Manko auf: Selbst einfache logische Umkehrschlüsse wie „wenn A gleich B ist, ist auch B gleich A“ stellen sie oft vor Probleme.

Kombinieren für KIs

Bereits Ende der 1980er Jahre argumentierten Forschende deshalb, dass künstliche neuronale Netze niemals in der Lage sein würden, es in Sachen Verallgemeinerung mit der menschlichen Kognition aufzunehmen. „Seitdem haben sich neuronale Netze erheblich weiterentwickelt, doch das Problem mit der systematischen Generalisierung blieb bestehen“, erklären Brenden Lake von der New York University und Marco Baroni von der Universität Pompeu Fabra in Barcelona.

Die grundlegende Herausforderung dabei: Für uns Menschen ist es selbstverständlich, gelernte Konzepte miteinander zu verknüpfen. Wenn wir wissen, was hüpfen und was rückwärts bedeutet, können wir problemlos auf Anweisung rückwärts hüpfen, ohne dies als neues Konzept eigens lernen zu müssen. Auch die Verbindung dieser Merkmale mit neuen Objekten oder Personen fällt uns leicht. Bisherige KIs dagegen wären mit einer solchen Verknüpfung überfordert.

Doch mit einer neuartigen künstlichen Intelligenz haben Lake und Baroni nun den Gegenbeweis angetreten. „Wir haben nachgewiesen, dass neuronale Netze eine menschenähnliche Systematik erreichen können, wenn ihre kombinatorischen Fähigkeiten dafür optimiert wurden“, berichten sie.

Systematisch und flexibel

Um ein künstliches neuronales Netz speziell für solche systematischen Verallgemeinerungen zu trainieren, wählten die Forscher einen neuen Ansatz des maschinellen Lernens, das sogenannte Meta-Lernen für Kompositionalität (MCL). Statt einen statischen Trainingsdatensatz zu verwenden, ermöglichten sie dem System dabei, sich nach jeder gelösten Aufgabe mit den neuen Informationen zu aktualisieren. Die Aufgaben passten sich dabei dynamisch dem jeweiligen Wissensstand des Systems an.

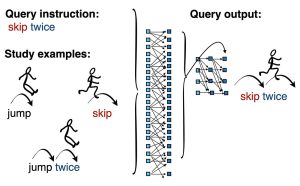

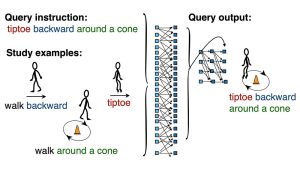

So lernte die KI beispielsweise die Bedeutung der Begriffe „rückwärts“, „auf Zehenspitzen“ und „um einen Kegel“, jeweils mit piktografischen Darstellungen. Im nächsten Schritt sollte sie eigenständig aufzeichnen, wie ein Strichmännchen „rückwärts auf Zehenspitzen um einen Kegel“ geht. Anschließend erhielt sie die richtige Lösung zum Vergleich und konnte sich damit aktualisieren.

Andere Modelle des maschinellen Lernens sind laut Lake und Baroni entweder zu unflexibel oder zu unsystematisch, um solche Aufgaben zu bewältigen. „Im Gegensatz dazu erreicht das Meta-Lernen für Kompositionalität sowohl die notwendige Systematik, als auch die Flexibilität, die für eine menschenähnliche Generalisierung erforderlich sind“, schreiben sie.

Logikrätsel in Fantasiesprache

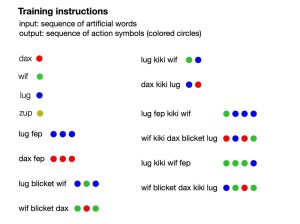

Um ihr auf diese Weise trainiertes neuronales Netz zu testen, ließen die beiden Forscher es gegen 25 menschliche Versuchspersonen antreten. Damit die Menschen keinen Vorteil dadurch hatten, dass sie bestimmte Wörter schon vorab kannten, erfanden die Forscher Fantasiebezeichnungen für die Farben rot, grün, grau und blau. Beispielsweise bedeutete „dax“ rot und „wif“ grün. Zusätzlich erfanden sie Wörter, die Verknüpfungen beschreiben. So bedeutete „kiki“ so viel wie vertauschen. „dax wif“ stand somit für rot grün, „dax kiki wif“ für grün rot.

Sowohl die menschlichen Testpersonen als auch die KI mussten sich diese Regeln aus einer kleinen Anzahl von Beispielen herleiten und anschließend auf neue Aufgaben anwenden. Dabei erhielten sie neue, komplexere Kombinationen von Anweisungen in der Phantasiesprache und sollten auf dieser Basis farbige Punkte in der korrekten Reihenfolge anordnen.

KI erreicht oder übertrifft menschliche Leistungen

Das Ergebnis: Die menschlichen Probanden wendeten die zuvor abgeleiteten Prinzipien in 80,7 Prozent der Fälle richtig an und fanden die korrekte Lösung. Auch bei Anweisungen, die deutlich komplexer waren als die Trainingsbeispiele, lagen sie in 72,5 Prozent der Fälle richtig. „Mit dieser Art der Generalisierung haben die meisten neuronalen Netzwerke Probleme“, ordnen die Forscher ein.

Nicht jedoch ihr eigens dafür trainiertes Modell: Im besten Durchlauf erreichte es eine Trefferquote von 100 Prozent und übertraf damit die besten menschlichen Versuchspersonen. In anderen Versuchen lag die Trefferquote mit 82,4 Prozent nahe der menschlichen Leistung und auch die Art der Fehler ähnelte denen, die auch die Menschen machten, wie die Wissenschaftler berichten. Beispielsweise neigten sowohl die Menschen als auch die KI dazu, Verknüpfungswörter mit Farbwörtern zu verwechseln.

„Unsere Ergebnisse zeigen erstmals, dass ein generisches neuronales Netz die systematische Generalisierung des Menschen in einem direkten Vergleich nachahmen oder sogar übertreffen kann“, sagt Lake. Während ChatGPT und Co. mit solchen Aufgaben bislang noch überfordert sind, könnte der neue Ansatz des maschinellen Lernens auch ihre Leistungsfähigkeit in Zukunft steigern. (Nature, 2023, doi: 10.1038/s41586-023-06668-3)

Quelle: Nature, New York University