Sprache aus Hirnsignalen: Forscher haben ein System entwickelt, das die Gedanken eines Menschen in hörbare und verständliche Sprache übersetzt. Ein neuronales Netzwerk wertet dabei die sprachtypischen Hirnsignale aus und wandelt sie mittels Vocoder in akustische Signale um. In ersten Tests war dieser „Gedanken-Übersetzer“ präziser und verständlicher als bisherige Ansätze, wie die Forscher berichten. Solche Systeme könnten künftig Gelähmten oder Stummen neue Sprache verleihen.

Sprache ist für unsere Kommunikation essenziell – umso verheerender ist es, wenn Menschen ihre Sprachfähigkeit durch Verletzung oder Krankheit verlieren. Schon länger versuchen Neurowissenschaftler daher, durch das Auslesen von Hirnsignalen eine direkte Schnittstelle zu unserem Denken zu schaffen. Denn wenn wir Worte hören oder sprechen, erzeugt dies charakteristische Aktivitätsmuster im Gehirn. Tatsächlich ist es Forschern bereits gelungen, gelesene Buchstaben und sogar gesprochene Sätze allein anhand der Hirnsignale zu rekonstruieren.

Verständlichkeit ist das Problem

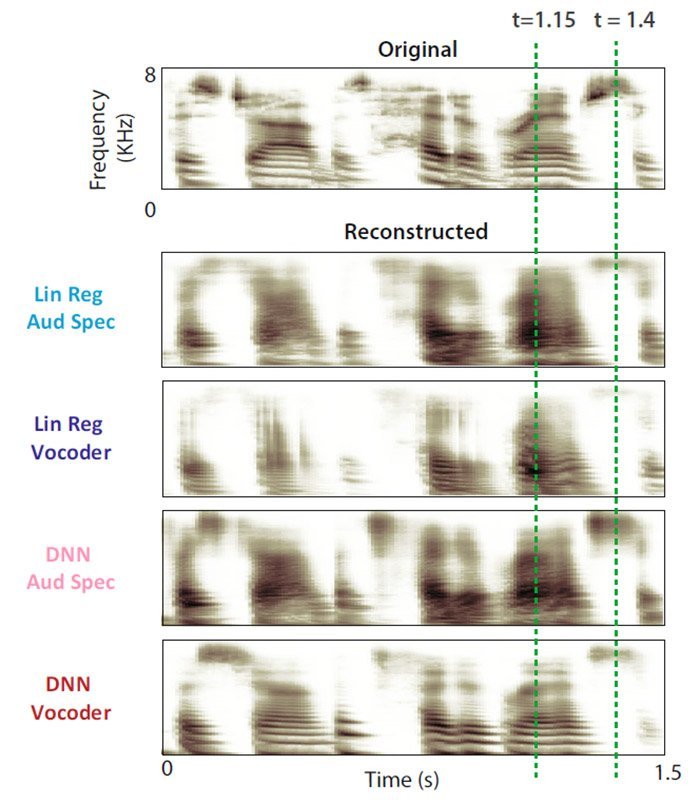

Doch bei der Umwandlung dieser Signale in akustische, verstehbare Sprache haperte es: „Die schlechte Qualität der rekonstruierten Sprache machte diese Methoden für Gehirn-zu-Computer-Anwendungen bisher kaum nutzbar“, erklären Hassan Akbari von der Columbia University in New York und seine Kollegen.

Das Problem: Bisherige Ansätze nutzten meist einfache Computermodelle, die akustische Spektrogramme analysieren und versuchen, sie den passenden Hirnsignalen zuzuordnen. „Wir wollten daher die Verständlichkeit der rekonstruierten Sprache erhöhen, indem wir die neuesten Fortschritte im Deep Learning mit den aktuellsten Innovationen der Sprachsynthese verknüpfen“, erklären die Forscher.