Schutz vor Manipulation: Forscher haben ein System entwickelt, das vor einer Manipulation und Verfälschung von Online-Bildern durch künstliche Intelligenz schützen kann. Dafür fügt das „UnGANable“ getaufte System ein nicht sichtbares Störrauschen auf der mathematisch-digitalen Ebene der Fotos ein. Dies stört das Auslesen der Bilder durch KI-Systeme und verhindert damit auch das Erstellen von veränderten Varianten dieser Fotos. In ersten Tests funktionierte diese Manipulationsblockade bereits besser als bisherige Schutzmethoden wie das Team berichtet.

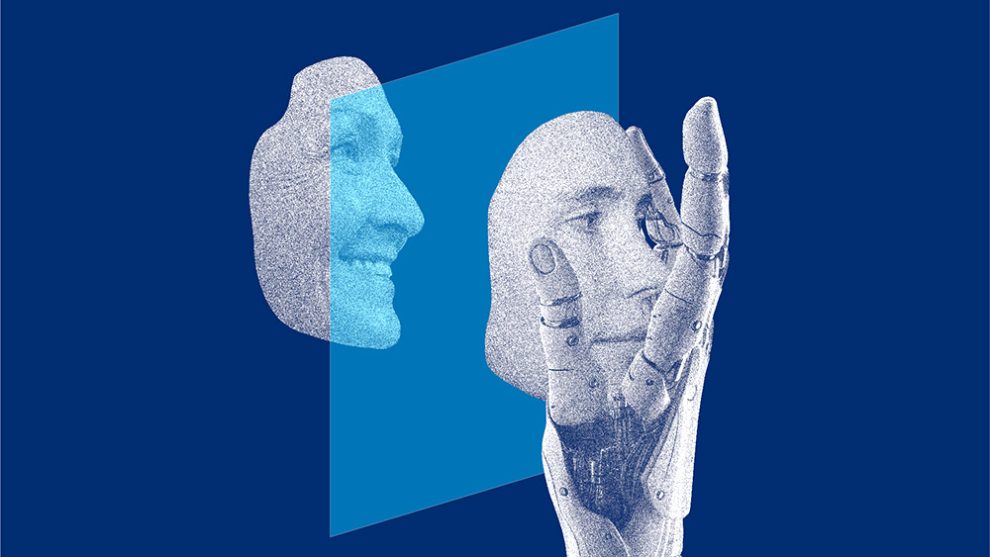

Fortschritte der künstlichen Intelligenz machen es heute immer einfacher, Bilder und Videos zu fälschen und Deepfakes zu erzeugen. Neben Text-zu-Bild-Generatoren wie Stable Diffusion oder DALL-E kommen dabei auch KI-Systeme zum Einsatz, mit denen sich digitale Bilder manipulieren lassen: Gesichtszüge, Mimik und Blickrichtung können verändert, Proportionen verzerrt werden. „Meist wissen die Personen auf den Fotos nichts von der Manipulation und können sich nicht mal dagegen wehren“, erklärt Erstautor Zheng Li vom CISPA Helmholtz Center for Information Security.

Wie Bildmanipulation durch GANs funktioniert

Eine wichtige Methode zur Erzeugung von Deepfakes ist die sogenannte GAN-Inversion. Grundlage dafür sind Generative Adversarial Networks (GAN), KI-Systeme, bei denen zwei künstliche neuronale Netze im Training miteinander wetteifern. Das erste neuronale Netz erstellt die Bilder oder Bildveränderungen, während das zweite versucht, diese künstlich erzeugten Bilder von echten zu unterscheiden. Durch diesen „Wettstreit“ entwickeln sich beide Teilsysteme immer weiter und damit auch die Qualität der erzeugten Bilder.

Damit GANs jedoch Bilder verarbeiten können, müssen sie diese zuerst in mathematische Vektoren, den sogenannten „latent code“ umwandeln. Dies wird als GAN-Inversion bezeichnet und stellt eine Art Bildkomprimierung dar. Mit Hilfe des „latent code“ eines realen Bildes kann ein Generator dann veränderte, aber täuschend echt erscheinende Kopien dieser Aufnahme generieren. Wie Li berichtet, gab es bisher kaum Möglichkeiten, Deepfakes auf Basis der GAN-Inversion zu verhindern.