Im wahrsten Sinne in den Mund gelegt: Die Mimik und Lippenbewegungen eines Sprechers überträgt ein internationales Forscherteam in Echtzeit auf das Videosignal eines anderen Menschen. Gestik und Kopfbewegungen bleiben dabei perfekt erhalten. Mit der raffinierten Bilderkennungstechnik sollen etwa bessere Filmsynchronisationen möglich sein – aber auch Live-Übertragungen sind damit anfällig für Manipulationen.

Live-Übertragungen im Fernsehen bringen wichtige Momente direkt ins Wohnzimmer, vom Fußball-Finale bis zu Ergebnissen der Bundestagswahl. Wir erfahren solche Ereignisse so unvermittelt und vor allem unverfälscht. „Live“ bedeutet für uns, dass wir tatsächlich sehen was geschieht.

Dynamische Videos als Herausforderung

Doch mit einem System, das Wissenschaftler um Christian Theobalt vom Max-Planck-Institutfür Informatik (MPII) in Saarbrücken entwickelt haben, wäre diese Unverfälschtheit nicht mehr so sicher: Ein Nachrichtensprecher etwa könnte auf dem Bildschirm sprechen, während er in Wahrheit nicht einmal den Mund öffnet – jemand anders steuert die Mundbewegungen täuschend echt.

Video-Streams zu manipulieren ist aber nicht das Ziel der Wissenschaftler: Sie beschäftigen sich schon lange mit dem „Verstehen von Bildern“ – mit der Herausforderung, dynamische Szenenmodelle von Videos zu erfassen. „Insbesondere geht es darum, Modelle aus Videodaten zu berechnen, um eine mathematisch, möglichst realitätsgetreue Beschreibung von starren, beweglichen aber auch deformierbaren Körpern innerhalb einer Szene zu schätzen“, sagt Christian Theobalt vom MPI. Genau das scheint den Forschern nun mit ihrem System geglückt zu sein.

Fotorealisitische Mimik in Echtzeit

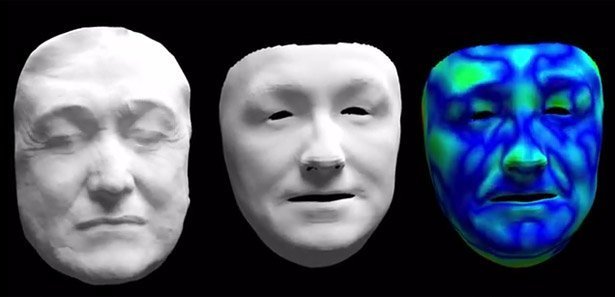

Bei dem neuen Verfahren werden zwei Personen von Kameras gefilmt, die zusätzlich zu normalen Bildinformationen auch weitere Informationen erfassen: Sie vermessen darüber hinaus die Entfernung jedes Bildpunktes in den Szenen. Basierend auf diesen Daten entwickelt das System dann ein Gesichtsmodell beider Personen, so dass die Kopfgeometrie und weitere Gesichtsinformationen in einer mathematischen Beschreibung vorliegen.

Danach werden Mimik und Lippenbewegung beider Personen analysiert und von einem Gesichtsmodell auf das andere übertragen, um sie im Zielvideo fotorealistisch darzustellen. Den Forschern zufolge ist dazu nicht einmal ein Hochleistungsrechner nötig: Die Algorithmen zur Berechnung sind so effizient, dass sie auf gut ausgestatteten Standardrechnern in Echtzeit ablaufen können.

Lippenbewegungen in Synchronsprache

„Grundsätzlich sind die Arbeiten als ein Baustein für Techniken zu verstehen, die es Computern ermöglichen, die bewegte Welt um sich herum zu erfassen, und mit vielen Anwendungen in der Robotik oder Augmented/Virtual Reality zu interagieren“, sagt Theobalt. Konkrete Anwendungsmöglichkeiten für ihr neues System sehen er und seine Kollegen in der visuellen Verbesserung von Synchronisierungen beispielsweise bei fremdsprachigen Spielfilmen: Mit dem Verfahren könnte man die Lippenbewegungen an die Synchronsprache angleichen.

Das Konzept wirft allerdings auch Bedenken auf: Täuschend echte Manipulationen von Live-Video-Streams scheinen nun möglich zu werden. „So, wie jeder heute weiß, dass Bilder und Filme für Werbe- oder auch Propagandazwecke verfälscht werden können, müssen auch bei vermeintlichen Live-Videos Manipulationsmöglichkeiten beachtet werden“, mahnen die Forscher.

(Max-Planck-Gesellschaft, 26.10.2015 – MVI)