Störrauschen kalkulierbar gemacht

Doch nun haben Kim und sein Team eine Technik vorgestellt, die Quantencomputer auch ohne perfekte Fehlerkorrektur praktisch nutzbar machen könnte. Der Clou dabei: Durch gezielte Verstärkung und Analyse des Störrauschens in ihrem System wird diese Fehlerquelle vorhersagbar. Das wiederum ermöglicht es, diese Störeffekte im Nachhinein herauszurechnen und zu ermitteln, wie das Ergebnis ohne das Störrauschen ausgesehen hätte. Im Prinzip erhält man damit das Ergebnis durch eine statistische Extrapolation.

Wie gut diese Zero Noise Extrapolation (ZNE) getaufte Methode funktioniert, haben Kim und seine Kollegen mit dem 127-Qubit-System „Quantum Eagle“ von IBM getestet. Mithilfe eines lernfähigen Algorithmus entwickelten sie dafür zunächst ein Modell, das das von der Position der Qubits, dem supraleitenden Material und anderen Faktoren abhängige Störrauschen für jedes Qubit rekonstruiert. „Je präziser das Störrauschen dafür verstärkt wird, desto geringer sind die resultierenden Verzerrungen im Modell“, erklärt das Team.

Quantum Eagle gegen zwei Supercomputer

Dann begann der eigentliche Test: Das Quantensystem musste sich gegen einen leistungsfähigen US-Supercomputer bewähren. Als Testaufgabe diente dabei jedoch nicht ein Problem, bei dem Quantencomputer schon per se einen Vorteil haben, sondern eine in der Festkörperphysik oft anfallende Aufgabe: Beide Systeme sollten die Verteilung von Teilchen und Feldern in einem magnetisierten 2D-Material berechnen. Dabei wurden die Rechnungen sukzessive komplexer gemacht.

Als Rivalen des IBM-Quantenrechners trat ein Team der University of California in Berkeley an, das auf die Entwicklung von effizienten Supercomputer-Algorithmen für solche Aufgaben spezialisiert ist. Zwei dieser sogenannten Tensor-Network-Berechnungen ließ das Team auf zwei US-Supercomputern laufen. „Vor dem Test war ich ziemlich sicher, dass die klassische Methode besser abschneiden würde als der Quantenrechner“, sagt Michael Zaletel vom Berkeley-Team.

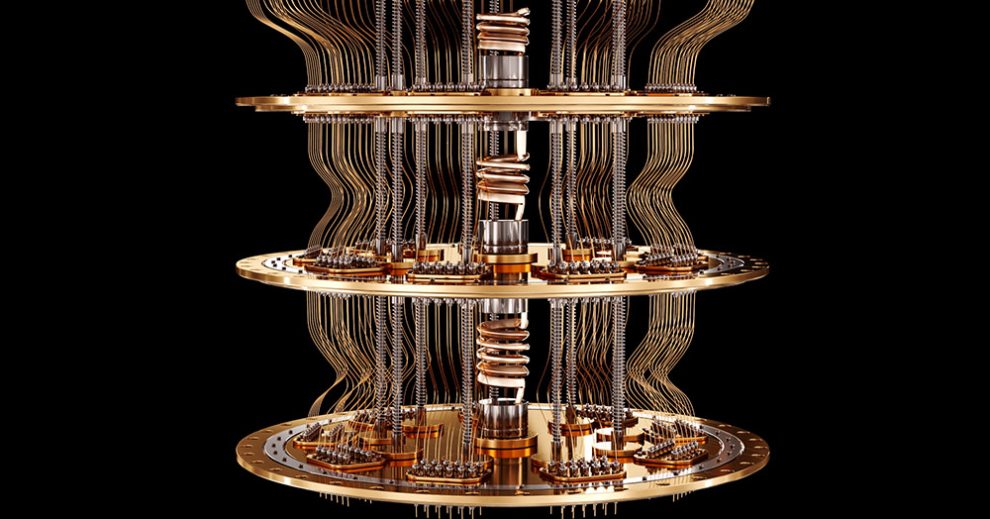

So funktioniert das Quantenrechnen mit Zero Noise Extrapolation.© IBM Quantum

Den Supercomputern überlegen

Doch es kam anders: In den ersten Phasen des Tests lieferten Quanten- und Supercomputer übereinstimmende Ergebnisse – ein Beleg dafür, dass die Zero Noise Extrapolation funktionierte. „Der Grad der Übereinstimmung bei so komplexen Problemen war selbst für mich überraschend“, sagt Andrew Eddings von IBM Quantum. Mit steigendem Komplexitätsgrad der Berechnungen wichen die Supercomputer dann immer stärker von den als richtig angenommenen Ergebnissen ab – doch wer hatte Recht?

Weil sich dies bei so komplexen Berechnungen nicht mehr eindeutig ermitteln lässt, nutzten die Forschungsteams eine Art Stichprobentechnik: Sie berechneten für bestimmte Parameter der Aufgabe die jeweils korrekten Werte und verglichen diese dann mit den Ergebnissen der konkurrierenden Rechnersysteme. Das Ergebnis: Die Supercomputer lagen falsch, während Quantum Eagles Resultate mit den Referenzwerten übereinstimmten.

„Auch wenn wir nicht mit letzter Sicherheit beweisen können, dass die Ergebnisse völlig korrekt sind, ist dies angesichts des Erfolgs von Quantum Eagle in den vorhergehenden Durchläufen des Experiments sehr wahrscheinlich“, konstatiert das IBM-Team. Zaletel sieht dies ähnlich: „Der Erfolg des Quantencomputers war kein Zufallstreffer, denn das System funktionierte für die ganze Gruppe von gestellten Problemen“, sagt er.

„Werkzeug für anderweitig schwer knackbare Probleme“

Nach Ansicht der Forschenden belegt dies, dass Quantencomputer selbst ohne Fehlerkorrektur-Systeme praktisch anwendbare und korrekte Ergebnisse liefern können. Es sei demnach durchaus sinnvoll und lohnend, solche Techniken der Rausch-Limitierung weiterzuverfolgen. „Das schlussfolgern wir aus der Beobachtung, dass ein verrauschter Quantenprozessor mit mehr als 100 Qubits und einer nicht-trivialen Schaltkreistiefe verlässliche, der Erwartung entsprechende Werte liefert“, schreiben Kim und seine Kollegen.

Das bedeutet zwar nicht, dass Quantencomputer der Zukunft ohne Fehlerkorrektur-Mechanismen auskommen werden. Die jetzt getestete Technik ermöglicht es aber, die Vorteile der Quantenrechner schon vor der Entwicklung solcher fehlertoleranten Systeme praktisch zu nutzen. „Wir können jetzt damit beginnen, Quantencomputer als Werkzeug zu sehen, mit dem wir anderweitig schwer knackbare Probleme angehen können“, sagt Koautorin Sarah Sheldon von IBM Quantum.

Ähnlich sehen es die nicht an der Studie beteiligten Forscher Göran Wendin und Jonas Bylander von der Chalmers University in Schweden: „Die Resultate von Kim und Kollegen zeigen Chancen für Quantenprozessoren, physikalische Systeme zu emulieren, die weit jenseits der Möglichkeiten konventioneller Computer liegen“, schreiben sie in einen begleitenden Kommentar in „Nature“. „Der fundamentale Quanten-Vorteil liegt dabei eher in der Größenordnung als im Tempo – die 127 Qubits berechnen ein Problem, für das kein klassischer Computer genügend Arbeitsspeicher hat.“ (Nature, 2023; doi: 10.1038/s41586-023-06096-3)

Quelle: IBM Quantum, University of California – Berkeley

16. Juni 2023

- Nadja Podbregar