Der Ton macht die Musik: Forscher haben herausgefunden, wie unser Gehirn subtile Veränderungen im Tonfall eines Sprechers wahrnimmt und verarbeitet. Dabei stießen sie auf Überraschungen: Beim Interpretieren des Tonfalls spielt unser Gehirn die Kehlkopfbewegungen nach, mit denen die Töne entstanden. Außerdem liegen die dazu nötigen komplexen Netzwerke von Nervenzellen in einer anderen Hirnhälfte als diejenigen zur Erkennung von Sprache, beschreiben die Neurologen im Magazin „Current Biology“.

Sprache ist mehr als nur aneinandergereihte Worte: Der Tonfall, in dem wir diese Worte aussprechen, trägt entscheidend zu deren Bedeutung bei. Oft verrät er sogar mehr über die Ansichten des Sprechers als die rein wörtliche Bedeutung des Gesagten. „Stellen Sie sich doch einfach mal ein leidenschaftlich, ein zögerlich oder ein ironisch gesprochenes ‚Ja‘ in Antwort auf einen Heiratsantrag vor“, schlägt Daniela Sammer vom Max-Planck-Instituts für Kognitions- und Neurowissenschaften in Leipzig vor. „Da haben Sie ein anschauliches Beispiel für die wichtige Funktion des Tonfalls.“

Auf die Verbindungen kommt es an

Diesen Aspekt der Sprache fassen Wissenschaftler unter dem Begriff Prosodie zusammen. Diese beinhaltet alle sprachlichen Eigenschaften wie Akzent, Intonation oder auch Sprechpausen. Wie das Gehirn diesen wichtigen Teil unserer Kommunikation verarbeitet, war jedoch bislang unklar.

Zwar ist bekannt, dass die reinen Wortlaute vor allem in den Sprachzentren der linken Gehirnhälfte entschlüsselt werden. Menschliches Verhalten und auch die Sprache lassen sich aber nicht nur auf einzelne Hirnregionen reduzieren – es kommt vor allem auf die Verbindungen zwischen den einzelnen Bereichen an. Solche existierenden Pfadmodelle lieferten bislang keine Anhaltspunkte über die Verarbeitung der Prosodie.

Aktive Regionen in der rechten Hirnhälfte

Neurologin Sammler und ihre Kollegen haben dies mit einem Experiment geändert. Die Forscher ließen Männer und Frauen mit Englisch als Muttersprache verschiedene Sprachaufgaben lösen. Sie sollten entweder entscheiden, ob Worte als Frage oder Aussage gesprochen wurden. Als Kontrolle sollten sie den Anfangsbuchstaben des gesprochenen Textes heraushören. Dabei maßen die Forscher die Gehrinfunktionen der Probanden mittels funktioneller Magnetresonanztomografie (fMRT).

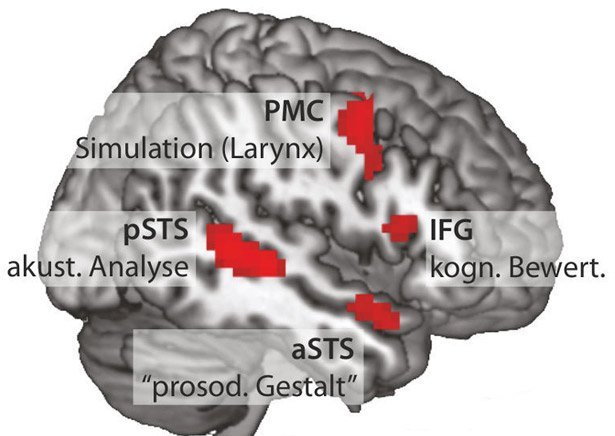

Die Ergebnisse zeigten zunächst zwei Gruppen aktiver Regionen in der rechten Hirnhälfte. Die erste Gruppe besteht aus dem vorderen und hinteren superioren temporalen Sulcus, der obersten der drei Furchen im Schläfenlappen des Gehirns. Diese Areale könnten Stationen sein, die den charakteristischen akustischen Verlauf der Tonhöhen bei Fragen oder Aussagen heraushören und entsprechend interpretieren, sagen die Forscher.

Gehirn stellt Bewegung des Kehlkopfes nach

Die zweite Gruppe bilden aktive Gebiete im sogenannten inferioren Frontallappen (IFG) und dem prämotorischen Kortex (PMC) in dem Areal, welches die Bewegungen des Kehlkopfes steuert. „Der IFG unterstützt die Bewertung des Tonfalls, während der PMC an dieser Stelle die Vibration der Stimmbänder und somit die Tonhöhe einer Äußerung kontrolliert“, erklärt Sammler. „Dieser Befund ist sehr interessant, da die Probanden die Stimuli lediglich hörten und nicht selbst sprachen.“

Die Studienteilnehmer stellten offenbar die nötigen Kehlkopfbewegungen, die der Sprecher jeweils für ein Wort benutzte, intern nach. Das Gehirn übersetzt Gehörtes also auch in einen Bewegungsbefehl. Dies fördert das Verständnis von Sprache, indem der Hörer in sich selbst das Gehirn die Bewegungsprogramme rekonstruiert, die ein Sprecher für die Produktion des Gehörten selbst genutzt hat. „Bislang vermutete man diesen Aspekt nur für die nichtprosodische Sprachverarbeitung in der linken Hemisphäre“, sagt Sammler. „Die vorliegenden Daten könnten aber für einen ähnlichen Mechanismus in der Wahrnehmung des Tonfalls sprechen.“

Feine Untertöne über flexible Pfade unterscheidbar

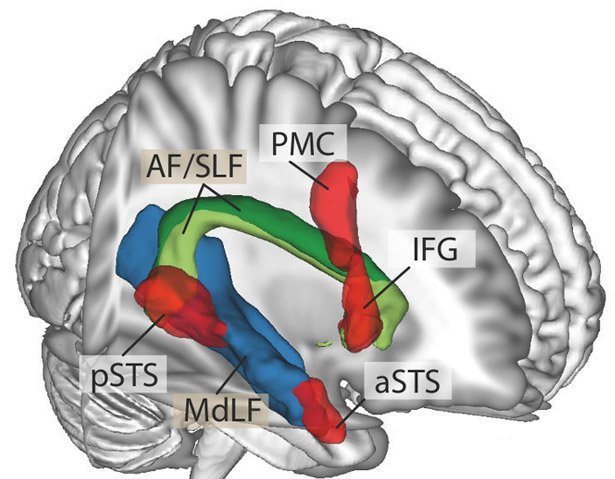

Darüber hinaus bestimmten die Forscher die Bündel von Nervenfasern der weißen Substanz, die dem Informationsaustausch in diesem Netzwerk zugrunde liegen. Dafür berechneten die Forscher die anatomischen Verbindungen zwischen den aktivierten Gehirnregionen aus den Gehirnbildern der Studienteilnehmer.

Die Ergebnisse zeigen deutlich zwei Faserbündel, die die beiden zuvor erkannten aktiven Gruppen in der rechten Hirnhälfte miteinander verbinden. Eines folgt dem sogenannten mittleren longitudinalen Fasciculus, das zweite dem folgt dem Verlauf des Fasciculus arcuatus beziehungsweise des superioren longitudinalen Fasciculus. Dieser ist in der linken Hemisphäre bereits als Verbindungsbahn zwischen den Sprachzentren bekannt.

Das Gehirn nimmt den Tonfall einer Sprache also entlang mehrerer Pfade wahr. Im Unterschied zu anderen Signalpfaden für Sprache liegen sie vor allem in der rechten Hirnhälfte. „Vermutlich lassen sich diese Pfade flexibel kombinieren und erfüllen so unterschiedliche Aufgaben“, fasst Sammler zusammen. „Dadurch kann das Gehirn feine Untertöne in der Stimme des Gegenübers erkennen.“ Die genaue Kenntnis dieses Prosodie-Netzwerkes helfe auch beim Verständnis zwischenmenschlicher Kommunikation und ihrer Störungen. (Current Biology, 2015; doi: 10.1016/j.cub.2015.10.009)

(Max-Planck-Institut für Kognitions- und Neurowissenschaften, 09.11.2015 – AKR)