Verschwörungstheorien im Aufwind: Über die sozialen Netzwerke verbreiten sich Gerüchte und Fehlinformationen besonders effektiv. Wie und warum, haben nun Forscher genauer untersucht. Dabei zeigt sich: Freundeskreise wirken wie Echokammern für Gerüchte und verstärken sie immer mehr. Im Gegensatz zu seriöse Meldungen wachsen dadurch Verschwörungstheorien im Netzwerk langsam zur Lawine heran, wie die Forscher im Fachmagazin „Proceedings of the National Academy of Sciences“ berichten.

Die sozialen Netzwerke verändern die Art, wie Informationen im Internet wahrgenommen und geteilt werden. Erst vor wenigen Monaten deckten US-Forscher auf, dass Facebook und Co eine Art Filter-Blase erzeugen: Unser Freundeskreis sorgt dafür, dass wir vorwiegend die Meldungen sehen, die ohnehin in unser Weltbild passen. Auch Stimmungen übertragen sich in diesen Netzwerken sehr schnell.

Eine der größten Bedrohungen

Aber nicht nur das: Gerade in sozialen Medien breiten sich auch Gerüchte und Verschwörungstheorien besonders schnell aus, wie Michela Del Vicario vom Labor für Computer-Sozialwissenschaften in Lucca und ihre Kollegen erklären. So kursierten während der Ebola-Epidemie Fehlinformationen, die das Pflegepersonal weltweit verunsicherte. Kürzlich erst mutierte zudem ein ganz normales Manöver der US-Streitkräfte mit dem Namen „Jade Helm 15“ im Netz zum Beginn eines Bürgerkriegs in den USA.

„Diese massive digitale Desinformation ist inzwischen so allgegenwärtig, dass das World Economic Forum (WEFG) sie als eine der Hauptbedrohungen für unsere Gesellschaft listet“, so die Forscher. Sie haben untersucht, welche Faktoren dafür sorgen, dass sich Gerüchte und Verschwörungstheorien so schnell im Netz verbreiten. Über einen Zeitraum von fünf Jahren verfolgten die Forscher bei 67 Facebook-Seiten, wer welche Nachrichten teilte und an wen. In 32 Seiten ging es dabei primär um Verschwörungstheorien, der Rest enthielt Wissenschafts-Meldungen.

„Echokammern“ als Verstärker

Das Ergebnis: Verschwörungstheorien und Wissenschafts-Meldungen haben bei ihrer Verbreitung im Netz durchaus Ähnlichkeiten: In beiden Fällen werden die Meldungen vor allem in Freundesnetzwerken Gleichgesinnter geteilt – aber jeweils in anderen. Zwischen ihnen jedoch gibt es keine Überlappungen, sie bilden sozusagen eigene Welten im Facebook-Universum.

„Unsere Auswertungen enthüllen, dass zwei ausgeprägte und hochgradig getrennte Gemeinschaften im Netz existieren, eine rund um die Verschwörungstheorien und eine bezogen auf wissenschaftliche Themen“, so Del Vicario und ihre Kollegen. Sie bezeichnen diese fast geschlossenen Kreise als „Echokammern“ – was hineinkommt, wird vielfach untereinander geteilt und verstärkt bereits vorab existierende Einstellungen. Das erklärt auch, warum es so schwer ist, hartnäckige Falschinformationen aus dem kollektiven Gedächtnis zu entfernen.

Strohfeuer versus Lawine

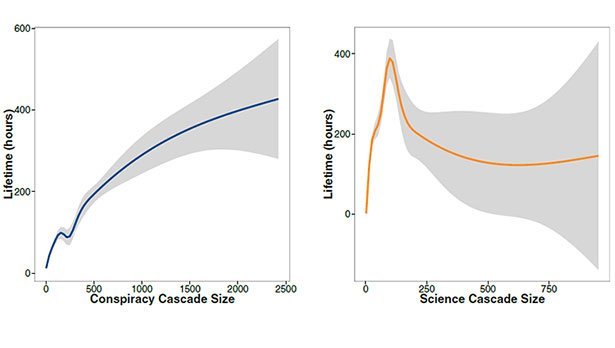

Zwar nehmen beide „Echokammern“ Informationen auf sehr ähnliche Weise auf, die Dynamik der Weitergabe unterscheidet sich jedoch deutlich: Bei den Wissenschafts-Meldungen wurde rund ein Viertel der Inhalte schon in den ersten zwei Stunden geteilt und verbreitet. Sie erreichen den Höhepunkt ihrer Verbreitung sehr schnell und das Interesse flaut relativ bald wieder ab – unabhängig davon, wie spannend die Meldung ist.

Anders bei den Gerüchten und Verschwörungstheorien: Sie verbreiten sich anfangs deutlich langsamer als die Wissenschaftsmeldungen. Dann jedoch wächst ihr Publikum und der Grad des Geteiltwerdens umso mehr, je länger die Meldung im Umlauf ist. Mit der Zeit kann eine Verschwörungstheorie dadurch zu einer wahren Lawine heranwachsen.

Was hilft gegen die Desinformation?

Was aber hilft gegen die unseriösen und oft komplett aus der Luft gegriffenen Gerüchte und Verschwörungstheorien? Google ist bereits dabei, eine Art Zuverlässigkeitsindex zu entwickeln, der den Grad der Glaubwürdigkeit eines Inhalts ermitteln und darstellen soll. „Solche Algorithmus-basierten Maßnahmen sind allerdings umstritten, denn sie wecken die Befürchtung, dass dadurch die freie Verbreitung von Inhalten im Netz eingeschränkt wird“, erklären Del Vicario und ihre Kollegen. Denn letztlich würde es sich dabei um eine Art der Zensur handeln.

Facebook überlegt dagegen einen eher nutzerorientierten Weg: Leser sollen über eine Markierung Meldungen im Newsfeed kennzeichnen können, die sie als falsch oder unseriös einschätzen. Die Wirksamkeit solcher Flags ist nach Ansicht der Forscher jedoch eher fraglich: Wenn sich solche Meldungen ohnehin vorwiegend unter Nutzern verbreiten, die dazu neigen, Verschwörungstheorien und Gerüchte zu glauben und nicht zu hinterfragen, werden sie diese wohl kaum als „falsch“ markieren. (Proceedings of the National Academy of Sciences (PNAS), 2016; doi: 10.1073/pnas.1517441113)

(PNAS, 05.01.2016 – NPO)