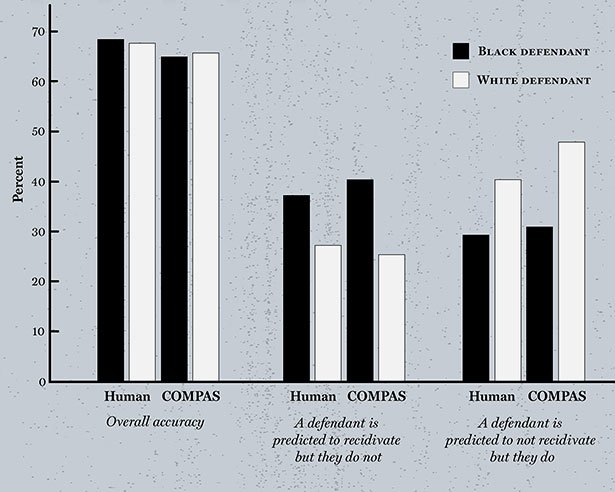

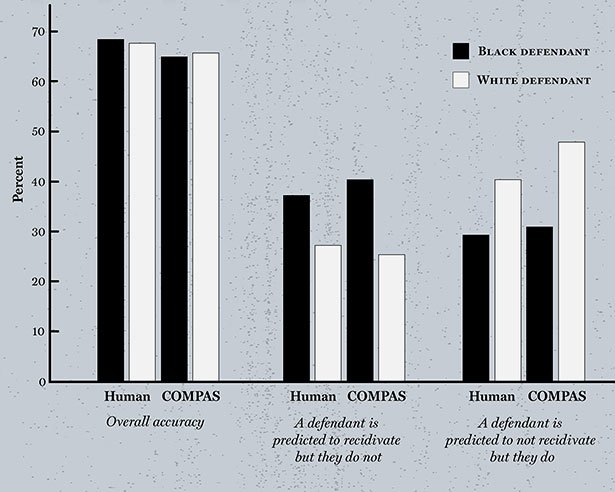

Trefferquote eher mau

Das Problem dabei: Die Prognose des Algorithmus kann das Urteil des Gerichts beeinflussen und damit letztlich das Schicksal des Angeklagten – und der Rechner liegt keineswegs immer richtig. Im Gegenteil: Als Forscher die Treffsicherheit von COMPAS auf Basis von 700 Fällen der Jahre 2013 und 2014 überprüften, stellten sie fest: Die Software lag nur bei rund 65 Prozent seiner Vorhersagen richtig.

Hinzu kommt: Obwohl die Software keine Angaben über die Rassenzugehörigkeit der Angeklagten bekam, machte sie klare Unterschiede. Bei Weißen irrte sie eher zugunsten der Angeklagten, bei Schwarzen dagegen prognostizierte sie doppelt so oft fälschlicherweise einen Rückfall. „Das weckt die Frage, ob diese Algorithmen überhaupt besser sind als ungeübte Laien, wenn es um eine faire und genaue Vorhersage dieser Art geht“, konstatieren Dressel und Farid.

Trefferquoten von COMPAS und Laien im Vergleich. © Carla Schaffer / AAAS

Blutige Laien contra Spezialsoftware

Genau das haben die Forscher jetzt in einem Experiment überprüft. Für 1.000 zuvor von COMPAS bewertete Fälle erstellten sie Kurzsteckbriefe der Angeklagten. Diese enthielten nur Angaben zu Alter und Geschlecht der Angeklagten, zur aktuellen Anklage und zu den Vorstrafen der Person. In einem weiteren Durchgang beschränkten die Forscher die Informationen sogar nur auf zwei Merkmale: Alter und Zahl der Vorstrafen.

Die Bewertung erfolgte durch 400 zufällig ausgewählte Internetnutzer ohne Vorerfahrungen in der Justiz. Sie bekamen jeweils 20 Täterprofile und sollten entscheiden, ob der Angeklagte ihrer Ansicht nach in den nächsten zwei Jahren eine weitere Straftat begehen würde oder nicht.

Der Algorithmus ist nicht besser

Das Ergebnis: Die Internetnutzer lagen in knapp 63 Prozent der Fälle richtig – und waren damit fast genauso gut wie COMPAS. Wurden ihre Entscheidungen zusammengenommen ausgewertet, stieg die Trefferquote sogar auf 67 Prozent. „Damit ist eine kleine Gruppe von Nichtexperten bei der Prognose der Rückfallwahrscheinlichkeit genauso treffsicher wie COMPAS – obwohl sie nur sieben Merkmale statt 137 bekommen hatten“, konstatieren die Forscher. Und selbst bei nur zwei Merkmalen lag ihre Trefferquote genauso hoch wie die der Software.

Interessant auch: In Bezug auf die – nicht genannte – Rassenzugehörigkeit der Straftäter entschieden die menschlichen Entscheider etwas weniger einseitig als die Software. Sowohl bei den falschpositiven als auch den falschnegativen Entscheidungen waren die Unterschiede zwischen weißen und schwarzen Angeklagten geringer als bei COMPAS.

„Das ist beunruhigend“

Nach Ansicht der Forscher wirft dies kein gutes Licht auf Algorithmen als Justizhelfer: „Es ist beunruhigend, dass bei diesen für die Betroffenen lebensverändernden Entscheidungen ein Computerprogramm nicht besser abschneidet als ungeübte Internetnutzer“, sagt Farid. „Diese Ergebnisse wecken erhebliche Zweifel an dem ganzen Ansatz, Algorithmen zur Rückfallprognose bei Straftätern einzusetzen.“

Zumal die geringe Trefferquote nicht auf das Beispiel COMPAS beschränkt ist: Wie eine Überprüfung vor Kurzem ergab, schneiden von neun verschiedenen Algorithmen zur Rückfall-Prognose acht ähnlich schwach ab wie das Northpointe-System. „Der Einsatz von Software zur Rückfallprognose in Gerichtssälen sollte grundsätzlich in Frage gestellt werden“, meint Dressel. (Science Advances, 2018; doi: 10.1126/sciadv.aao5580)

(AAAS, 18.01.2018 – NPO)

18. Januar 2018